IA générative: le guide ultime du hater anti-chatGPT.

Les arguments imparables pour faire de n'importe quel interlocuteur un hater de l'IA générative, histoire d'aborder les fêtes de Noël avec les munitions nécessaires pour parer toute discussion pro-IA.

Chat GPT vient de souffler sa troisième bougie. Et avec les fêtes de fin d’année, le sujet de l’IA générative pourrait bien s’inviter à votre table. Que répondre aux techno-béats qui ne sont pas convaincus qu’il faut brûler les data centers, nationaliser Mistral et jeter Sam Altman, le transhumaniste accroc aux drogues et patron d’OpenAI, en prison ? C’est l’objet de ce numéro un peu spécial de “Fake Tech”.

Avant de débuter ma longue diatribe, je voudrais préciser qu’elle m’a été en partie inspirée par le style du journaliste britannique Ed Zitron. Si vous lisez l’anglais et que les articles de 15 000 mots centrés sur un aspect particulier de la critique de l’IA générative ne vous font pas peur, je vous encourage à lire sa newsletter.

Sinon, il ne vous reste plus qu’à vous abonner à FakeTech ou à partager cette publication autour de vous. Cela fait toujours plaisir de voir le compteur à abonnés progresser, sans parler de ceux qui prennent le temps de m’offrir un café (ici). Bonne lecture et joyeuses fêtes !

Le terme IA générative désigne les programmes informatiques capables de produire des contenus inédits (textes, vidéos, audio, code informatique…) à partir de simples requêtes (prompt). Pensez ChatGPT, Sora, Claude, etc. C’est de ces IA, basées sur les « Larges modèles de langage » (LLM), dont nous parlerons ici, pas du régulateur de vitesse du Scénic de mon oncle.

Avant de répondre aux arguments typiquement déployés par les fans d’IA, commençons par résumer ce que l’on sait des conséquences concrètes de cette technologie.

Les IA génératives imposent un cout catastrophique et engendrent des conséquences désastreuses

Pour fonctionner, les IA génératives nécessitent des quantités phénoménales d’électricité, de métaux lourds, de terres rares, de terres arables, d’eau potable et de données. Ces données sont presque exclusivement volées. À vous, à moi, aux artistes, aux travailleurs, aux collectivités et aux entreprises. Elles sont traitées par des millions d’êtres humains payés à la tache et travaillant dans des conditions traumatisantes, au point de pousser certains d’entre eux au suicide ou au meurtre. Sans surprise, la majorité de ces travailleurs sous-payés vivent dans le “sud global”. On est pas loin de l’esclavage moderne, comme le montrait le documentaire “les sacrifiés de l’IA”.

Une fois mises au point, les IA génératives servent de justification à des plans de licenciements massifs et à la destruction des services publics. Elles sont utilisées pour la production de fausses informations destinées à manipuler les électeurs ou à inciter à la haine. Ces contenus, caractérisés par leurs mauvaise qualité, erreurs ou absence d’objectifs précis, ont donné naissance au terme “IA slop” (bouillie). Ils inondent internet, souvent pour capter notre attention à moindres frais, et compliquent la recherche d’informations authentiques.

Dans les entreprises, les productions de mauvaise qualité résultant de l’usage de l’IA possèdent désormais leur propre terme : “workslop”. Quant aux IA fonctionnelles, elles introduisent le problème du deskilling (perte de compétence). Diverses études ont démontré que l’IA générative réduisait l’esprit critique des utilisateurs, manipulait leurs opinions et diminuait leurs capacités cognitives. Autrement dit, l’IA nous abrutit, en plus d’accaparer notre attention.

ChatGPT et les autres agents conversationnels utilisés par le grand public sont explicitement conçus pour être addictifs et manipulateurs. Ils ont déjà poussé plusieurs personnes au suicide ou au meurtre et provoqué des accidents. Sans produire la moindre remise en question. Sam Altman (OpenAI) a récemment indiqué que les prochaines versions de son chatbot seront autorisées à entretenir des relations amoureuses ou érotiques. En parallèle, il recommande aux parents d’utiliser son IA pour apprendre à élever leurs enfants au quotidien. Tout est bon pour imposer l’usage de l’IA, malgré les risques qu’elle représente.

Cet été, les conseils vacances de ChatGPT and Co ont été identifiés comme une des causes du nombre record d’accidents mortels dans les alpes italiennes (les vacanciers s’engageant sur des itinéraires trop techniques et sans préparation adaptée, sur les conseils de l’application). Et les choses ne semblent pas destinées à s’améliorer : comme l’a rapporté The Guardian, une étude vient de démontrer que ChatGPT-5 était plus dangereux pour les utilisateurs que la version antérieure. Notamment, le tout dernier modèle d’OpenAI a plus de chance de produire des réponses néfastes (type : conseil pour se suicider ou commettre des actes illégaux). L’étude conclut que ChatGPT5 a été conçu pour augmenter l’engagement des utilisateurs.

Dans la même veine, le chatbot de Facebook démarchait des utilisateurs afin de leur fixer des rendez-vous galants (un homme souffrant d’insuffisance cardiaque en est mort). Le programme ciblait également les enfants.

Le but de toutes ces applications n’est pas d’aider l’utilisateur, mais de le rendre accro. Or, les LLM sont connus pour leurs nombreux biais (homophobes, racistes, machistes, patriarcaux, bourgeois, anglo-saxons, occidentaux…). Dans le cas de Grok, l’IA d’Elon Musk, cela prend des proportions délirantes (propos ouvertement antisémites, nazis…). Mais même les IA réputées bienveillantes et “humanistes” reproduisent les biais liés à leurs données d’entrainement et à leurs procédés de production (plus de 80 % des ingénieurs et scientifiques qui construisent ces IA sont des hommes, une majorité d’entre eux sont blancs et anglophones).

Les IA génératives introduisent aussi d’innombrables risques, en termes de sécurité et de cybersécurité. Elles peuvent aider leurs utilisateurs à commettre des actes malfaisants ou illicites malgré les garde-fous facilement contournables. Elles peuvent encourager leurs interlocuteurs à adopter des comportements autodestructeurs. Mais elles peuvent aussi profiter aux cybercriminels, que ce soit directement en les aidant à commettre des actes de piratage ou indirectement en exposant les utilisateurs aux failles informatiques spécifiquement véhiculées par ces systèmes. En particulier, il est possible de faire régurgiter à une IA ses données d’entrainement, ce qui augmente le risque que vos informations les plus intimes soient exposées.

Enfin, développer ces IA coute une fortune. Les investissements se chiffrent en milliers de milliards de dollars. Non seulement cela monopolise des ressources qui auraient pu être déployées pour financer des choses plus utiles (des panneaux solaires et éoliennes pour combattre la crise climatique, à la place des data centers et GPU utilisés pour créer des actrices pornos virtuelles, par exemple). Mais cela introduit aussi de sérieux risques de crise financière.

Ces “défauts” sont bien connus et documentés. Pourtant, depuis la sortie de ChatGPT, aucune régulation sérieuse n’a vu le jour. OpenAI et consorts continuent de piller les données privées et sous copyright, tout en provoquant la mort de certains de leurs utilisateurs, sans que cela provoque la moindre réaction. Même l’IA Act européen ne prévoit aucune disposition contraignante. Comme l’écrit Thibeaut Prévost dans son excellent ouvrage “Les prophètes de l’IA” :

« [Les entreprises qui commercialisent des IA génératives n’auront] à fournir ni documentation technique ni analyse d’impact de leurs modèles avant la mise sur le marché, pas plus qu’elles n’auront à se plier à des audits de sécurité externes, à démontrer l’interprétabilité de leurs modèles, à fournir des outils pour différencier un contenu synthétique d’un contenu humain, ou à respecter la Directive européenne sur le copyright pour leurs données d’entraînement. Alors que le Parlement voulait initialement imposer ces contraintes à tous les systèmes d’IA «à but général», comme GPT-4, elles sont désormais réservées aux IA à usage général présentant un «risque systémique», soit aucun des systèmes actuellement commercialisés. »

Les principales critiques de l’IA portent sur la dangerosité supposée de cette technologie. Il ne se passe plus une semaine sans qu’un chercheur ou spécialiste alerte dans un grand journal sur le risque existentiel de ces IA génératives. En réalité, ces prophètes de malheur contribuent à entretenir le mythe d’une technologie toute puissante. En se focalisant sur des risques hypothétiques et lointains, ils détournent notre attention des nombreux problèmes posés par l’IA ici et maintenant.

Je vais terminer cette introduction en soulignant une dernière absurdité. Les principaux acteurs de l’IA (les grands patrons et financiers de la Silicon Valley) ne cachent pas leurs intentions: mettre un maximum d’entre nous au chômage (tout en proposant de nous payer un revenu universel proche du RSA, qui serait financé par leurs profits colossaux) et nous rendre accros aux chatbots désormais conçus pour être nos amants virtuels et nous “décharger” de choses aussi intimes que l’éducation de nos enfants, la gestion de nos relations amoureuses et amicales, tout en nous empêchant de faire le deuil de nos proches. Un beau projet dont l’aboutissement reste incertain, mais les conséquences immédiates déjà catastrophiques.

L’IA générative produit pratiquement autant de gaz à effet de serre que le transport aérien. Et ça ne fait que trois ans que cette technologie est disponible pour le grand public. Début 2022, personne n’avait entendu parler de ChatGPT. S’il fallait revenir en arrière et choisir entre ne plus jamais faire décoller le moindre avion de ligne ou ne jamais commercialiser les chatbots à grande échelle, la décision serait probablement rapidement prise. Je prends cet exemple pour montrer à quel point le rapport coût-bénéfice est disproportionné.

Le plus choquant étant peut-être le fait que cette ruée sur les data centers va augmenter significativement le prix des autres appareils électroniques, les fabricants de composants modifiant leurs lignes de production pour répondre l’explosion de la demande en composants exclusivement dédiés à l’IA.

La seule attitude raisonnable, lorsqu’on dispose de la somme d’informations dont je viens de vous abreuver en guise d’introduction, est de vouer une haine juste et entière à ChatGPT, ses concurrents et les entreprises, influenceurs et patrons qui sont derrière. Je ne dis pas qu’il faille reprocher à tout un chacun de demander à ChatGPT une recette de cuisine ou des idées de cadeaux pour la Saint-Valentin. Je dis que donner le moindre euro à ces entreprises devrait être aussi condamnable et stigmatisant que de faire un don défiscalisé à une compagnie pétrolière, travailler pour un marchand d’armes ou financer les fabricants de tabac.

Je vous vois venir, avec vos objections. Vous allez me dire que la technologie évolue vite, qu’il ne faut pas jeter le bébé avec l’eau du bain, qu’il n’y a pas d’alternative (tu veux revenir au modèle amish ? Laisser l’IA aux Chinois ?)… Passez-moi cette coupe de champagne.

Les IA génératives ne fonctionnent pas (et elles ne vont pas vous remplacer) !

Je pourrais commencer par détailler le fonctionnement de ChatGPT et autres IA génératives pour démontrer qu’il s’agit de modèles statistiques visant à prédire, en interpolant les données avec lesquelles ils ont été entrainés, le mot le plus plausible à ajouter à la suite d’une phrase. La nature probabiliste implique la faillibilité du modèle. Et le fait qu’il cherche à produire la réponse la plus plausible signifie que le modèle ne cherche pas la vérité ou l’originalité, mais la proximité avec les données d’entraînement. Autrement dit, il est impossible de mettre au point une IA générative qui ne commettrait pas d’erreurs, raisonnerait ou comprendrait ce qu’elle fait, à partir des LLM.

Cette caractéristique indépassable explique pourquoi les IA génératives se trompent souvent, semblent dépourvues de sens commun et ne pourront pas devenir conscientes ou intelligentes.

Plusieurs études produites par les laboratoires de recherche d’Apple et par des universitaires ont montré que les modèles d’IA générative les plus aboutis et censés raisonner (“chain reasoning model”) comme ChatGPT4-o1, ne sont pas dotés de capacités cognitives. Pour résoudre des problèmes de mathématiques complexes, par exemple, ils piochent dans leurs données d’entrainement pour aboutir à la solution (un peu comme un cancre qui copie par-dessus l’épaule de son voisin ou dans un manuel scolaire).

Ces mêmes modèles “raisonnant” ont été testés pour générer des dépêches et des résumés d’articles de presse. Dans 50 % des cas, ils produisent des communiqués contenant des erreurs factuelles. Un taux d’erreur proprement hallucinant. Une autre étude récente vient de démontrer qu’un nouvel article scientifique sur 6 serait contaminé par de fausses citations produites par des IA types ChatGPT.

En résumé, les IA génératives ne fonctionnent pas !

Lorsqu’on a dit cela, les fans de l’IA vous répondront qu’ils arrivent à faire des choses extraordinaires avec Google IA studio, Claude ou ChatGPT. Que d’innombrables entreprises licencient en invoquant les gains de productivité permis par l’IA. Que des métiers connaissent de grandes difficultés (graphistes et illustrateurs, concepteur-rédacteurs, traducteurs…). Bref que les IA sont peut-être imparfaites, mais se perfectionnent et sont déjà suffisamment puissantes pour menacer des millions d’emplois.

Bien. Regardons ce que dit le marché et le monde des affaires.

Du côté des entreprises, nous disposons d’une pléthore de rapports et études qui pointent l’inefficacité des IA.

La dernière étude du MIT, portant sur un large éventail d’entreprises, a conclu que le développement de l’IA générative n’a apporté des bénéfices que dans 5 % des cas. La principale raison identifiée est directement liée aux faibles capacités de l’IA générative . Je cite : « ce qui la freine réellement, c’est que la plupart des outils d’IA n’apprennent pas et ne s’intègrent pas bien dans les processus».

Une enquête similaire du cabinet de conseil KPMG a conclu que seulement 2 % des entreprises canadiennes ayant adopté l’IA générative observent un retour sur investissement positif (deux cas sur cent !).

Le rapport IA 2025 de McKinsey a conclu que « seulement une entreprise sur vingt est un “acteur performant”, ayant profondément intégré l’IA et constatant qu’elle génère plus de 5 % de leurs bénéfices ». Selon l’étude, seuls 32 % des dirigeants interrogés pensent que l’IA générative va leur permettre de réduire leur nombre d’employés et 61 % estiment que l’adoption de l’IA est un échec.

Des rapports récents montrent une forte baisse de l’utilisation de l’IA générative par les développeurs et programmeurs. De plus, une étude majeure a conclu que l’IA générative réduisait la productivité des développeurs de logiciels de 20 %. La conclusion la plus intéressante de l’étude est que les ingénieurs qui ont vu leur productivité décroitre pensaient pourtant qu’elle avait augmenté. Ce qui signifie que de nombreuses études basées sur les déclarations des personnes interrogées surestiment probablement l’apport de l’IA.

The Economist vient de publier un article confirmant ces tendances. Le journal note que « Les enquêtes récentes indiquent une stagnation de l’adoption par les entreprises » et que l’utilisation de l’IA générative recule (« Jon Hartley de l’Université Stanford et ses collègues ont constaté qu’en septembre, 37 % des Américains utilisaient l’IA générative au travail, contre 46 % en juin »).

La Harvard Business Review vient de publier un article sur le problème généré par le phénomène de “IA workslop”. Pour la prestigieuse publication, “la bouillie produite par les IA détruit la productivité” et “bien que les employés suivent les directives leur demandant d’adopter l’IA, rares sont ceux qui expérimentent des gains de productivité”.

Bloomberg a publié plusieurs articles récents soulignant l’absence de gains de productivité liés à l’adoption de l’IA, dont un, intitulé : « L’engouement pour l’IA s’avère être un paradoxe de Solow » (un terme inventé par le lauréat du prix Nobel d’économie Robert Solow, qui notait en 1987 : « On retrouve les ordinateurs partout, sauf dans les statistiques de productivité »).

De nombreux dirigeants d’entreprise ont publiquement exprimé leurs réserves concernant la technologie. Le PDG d’Airbnb, Brian Chesky, a récemment admis que l’IA « n’était pas encore prête » pour la planification de voyages et qu’au sein de sa propre organisation « elle ne conduit pas encore à un changement fondamental de productivité ». Le PDG d’AWS affirme que remplacer les employés juniors par l’IA est « l’idée la plus stupide qu’il soit».

Différents cas d’entreprises ayant licencié des employés pour les remplacer par de l’IA avant d’être contraintes de les réembaucher ont récemment fait les gros titres.

Ces faits sont dévastateurs. Malgré la hype qui pousse les entreprises et dirigeants à adopter l’IA et à se vanter des succès obtenus (cela fait moderne, rassure les investisseurs, discipline les employés…), l’IA ne perce pas au sein du privé.

Et les choses ne sont guère meilleures côté grand public.

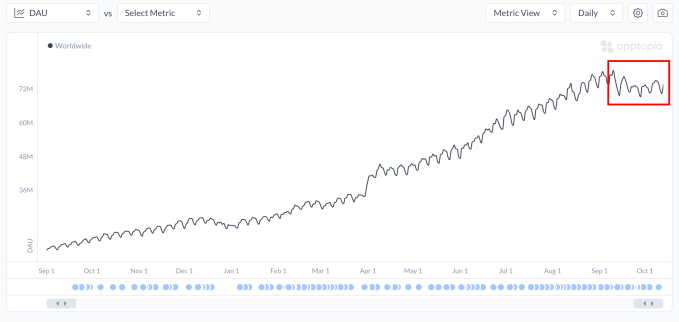

En Europe, la Deutsche Bank note une stagnation voire un recul du nombre des souscriptions. Cette tendance est confirmée par les données collectées par les analystes de Apptopia, citées par Techcrunch. Le nombre de téléchargements de ChatGPT recule et le nombre d’heures passées par les Américains sur l’application connait une baisse de 22% depuis juillet. Ce qui explique pourquoi une dirigeante d’OpenAI se plaignait du “manque d’enthousiasme pour l’IA” (sic) la semaine dernière.

Les mauvais chiffres d’OpenAI, leader incontesté du marché grand public, sont antérieurs à l’irruption de Gemini 3, le modèle de Google qui dépasse ChatGPT5. Ils pointent vers une tendance globale.

Plus anecdotique, deux tentatives récentes d’utiliser commercialement des vidéos générées par une IA ont tourné à la catastrophe. Amazon a supprimé son résumé vidéo de la série Fall Out après le signalement de multiples erreurs commises par l’IA. Et suite au backlash sucité par les consommateurs, la publicité produite par McDonald a été retirée en urgence. Le pire étant que les producteurs de la publicité déclaraient avoir “travailler 24h/24 pendant des jours” pour tenir les délais et améliorer les prompts, en insistant sur le fait que “ce n’est pas l’IA qui a fait la vidéo, c’est nous”. En clair, les publicités générées par l’IA sont moches, désastreuses et ne coutent pas nécessairement moins cher à produire. Le contraste entre la réception de la publicité McDonald et celle, devenue virale à travers le monde, d’Intermarché est saisissant. Dans le cas de la seconde, c’est une agence marketing basée à Paris et un studio d’animation français qui ont réalisé la vidéo, avec des employés en chair et en os.

Certes, l’IA reposant sur les réseaux de neurones artificiels et le deep learning peut offrir quelques applications intéressantes. Le prix Nobel de chimie a été attribué à deux chercheurs de Google Deep Mind dont l’algorithme a permis de prédire les structures complexes des protéines. Leurs travaux devraient permettre d’accélérer la découverte des médicaments. Plus controversé, l’usage de l’IA pour diagnostiquer les radios permet un gain de temps évident. Sans avoir remplacé les radiologues pour autant. Malgré une envie débordante de remplacer les travailleurs par des IA, nous n’avons pas encore vu des signes clairs et abondants d’emplois remplacés par cette technologie.

Les raisons sont multiples : les IA fonctionnent mal, les emplois ne se résument pas à des tâches uniques ou même un ensemble de tâches automatisables. Contrairement à ce que pensent parfois les dirigeants qui s’en servent de prétexte pour licencier.

Ce n’est pas l’IA qui vous vire ou vous remplace, mais votre patron et vos dirigeants. Le journaliste américain Brian Merchant enquête depuis des mois sur la question du remplacement d’emplois par l’IA. Son travail n’est pas conclusif : certaines professions sont sévèrement impactées, d’autres non. Le cas d’Amazon est emblématique. La firme s’est vantée de virer 30 000 employés en invoquant l’IA, mais des salariés ont répliqué par communiqué de presse en expliquant qu’aucun gain de productivité n’avait été observé. Plusieurs milliers ont même signé une lettre ouverte remettant fondamentalement en cause la politique pro-IA d’Amazon.

Pour Brian Merchant, l’impact de l’IA sur le marché du travail reste impossible à déterminer. Le cas des traducteurs est intéressant : l’IA ne remplace pas nécessairement les emplois, mais dégrade le travail. Ces derniers doivent relire et corriger les traductions de l’IA au lieu de traduire les textes eux-mêmes. Le procédé créatif est sous-traité, ne laissant que les taches rébarbatives aux humains. Cette tendance s’observe dans de nombreuses professions où les postes supprimés ne sont pas dus à la performance de l’IA, mais au fait que les dirigeants acceptent une qualité de production inférieure. Selon Merchant, une seule chose est certaine “Le patronat utilise l’IA comme il a toujours utilisé les technologies d’automatisation depuis la révolution industrielle, pour extraire un maximum de valeur de ses travailleurs tout en profitant de l’incertitude générée par les capacités de cette technologie”. Un point de vue qui rejoint en quelque sorte celui du sociologue Juan Sebastian Carbonel qui, dans “Un taylorisme augmenté”, montre bien que l’IA sert avant tout à dégrader les conditions de travail et exploiter davantage les employés, pas à les remplacer.

Les IA génératives ne vont pas devenir intelligentes, conscientes ou toutes puissantes (l’IApocalypse est de la science-fiction pour vous manipuler)

Puisque l’IA progresse très vite, certains s’imaginent que nous allons rapidement aboutir à des IA aussi douées que l’homme (l’AGI pour Intelligence artificielle générale) voire arriver à la singularité (une IA consciente et capable de s’autoaméliorer, donc de dépasser très rapidement l’homme). D’où les discours apocalyptiques sur la dangerosité de la recherche en IA et les promesses d’un futur radieux où l’IA résoudra tous nos problèmes et nous permettra de vivre dans l’abondance.

Certes, le fossé qui sépare ChatGPT-3 des derniers LLM est tout aussi impressionnant que les progrès réalisés du côté des générateurs d’images. En trois ans, on est passé des photos difformes à des spots publicitaires très réalistes. Il y a trente ans, Deep Blue battait Gary Gasparov de justesse aux échecs. Désormais, n’importe quel iPhone peut vaincre Magnus Carlsen à plate couture. Il semble naturel d’anticiper de nouveaux bonds technologiques dépassant l’entendement.

Le problème avec l’argument du progrès exponentiel est qu’il ignore les principes sous-jacents aux modèles d’IA reposant sur l’apprentissage profond et les LLM. De la même manière qu’on ne peut pas extrapoler la taille d’un adulte à partir de la courbe de croissance d’un bébé (qui ne double pas de poids tous les trois mois indéfiniment), les LLM ne doublent pas leur puissance ou leur capacité à chaque nouvelle version. Les principaux scientifiques qui pensaient qu’il existait une loi de scalabilité (scaling law) selon laquelle la puissance du modèle évoluait en proportion de la complexité de ce dernier (nombre de paramètres et volume de données utilisées pour l’entrainer) admettent désormais que l’augmentation de la taille des modèles n’améliore plus significativement leur performance. Le rendement devient décroissant, puis négatif.

Il ne faut donc pas s’attendre à des sauts qualitatifs perpétuels. On a déjà vu à quel point ChatGPT-5 avait déçu. Et la nouvelle version 5.2 abandonne la principale innovation de ChatGPT-5, le fameux “routeur” qui dirigeait le logiciel vers un sous-modèle spécifique en fonction de la requête de l’utilisateur. L’idée était d’éviter de monopoliser les ressources des modèles les plus complexes (capables de raisonnement par étape ou chain reasoning) si l’utilisateur pose une question simple. Derrière le concept, on voit poindre la notion d’agents automatisés capable de distribuer les tâches : puisque OpenAI ne parvient pas à construire un modèle tout puissant, pourquoi ne pas proposer une constellation de sous-modèles plus spécifique ? Dans les faits, le routeur ne parvenait pas à orienter correctement les utilisateurs et utilisait davantage les modèles les plus complexes. Avec deux conséquences : une surconsommation d’énergie et des utilisateurs frustrés par des réponses longues et lentes à des questions simples. Ce qui illustre une fois de plus la limite de l’IA générative, incapable de dépasser certaines limites intrinsèques à son fonctionnement. On est loin d’une IA générale, comme l’explique depuis des mois Yann Lecun, considéré comme un des pères du deep learning. Ancien directeur de la recherche chez Facebook, il affirme depuis quelque temps que l’approche actuelle reposant sur les LLM constitue un détour ou une voie de garage pour ceux qui espèrent aboutir à une IA égale ou supérieure à l’homme.

Pourtant, les boss de la Silicon Valley et de nombreux grands noms de l’IA continuent de vendre une vision apocalyptique. Certains le font certainement par intérêt, d’autres par conviction. On peut être un spécialiste en algorithme de Deep Learning et se tromper lourdement sur ce qu’est l’intelligence ou la capacité de tels algorithmes à l’atteindre.

L’idée même qu’on peut répliquer l’intelligence humaine et la conscience en simulant mathématiquement des neurones et en les arrangeant en réseau est risible. Cela témoigne davantage d’une vision réductrice de ce qui fait de nous des humains plutôt que d’une vision extensive de ce que les machines peuvent produire.

Comme le rappel Thibault Prévost :

« Nous ne sommes pas le «cerveau dans une cuve» imaginé par le philosophe Hilary Putnam en 1981[6]. Non seulement il n’y a pas d’intelligence sans corps – le processus de mémoire, par exemple, est décentralisé –, mais l’expérience démontre qu’il y a de l’intelligence sans cerveau – d’autres cellules que les neurones sont capables de stocker de l’information et de la manipuler, et c’est ce qu’on appelle la cognition fondamentale ».

L’autre mythe perpétué par les chantres de l’IA issus de la Silicon Valley a trait au risque existentiel, basé sur la théorie du maximisateur de trombone. Il serait trop fastidieux de rappeler ici de quoi il s’agit. Je vous renvoie donc à l’excellent article de Huber Guillaud.

Résumons tout de même quelques points. D’abord, la peur de l’avènement d’une machine qui, pour maximiser sa production (des trombones, par exemple), en viendrait à supprimer l’humanité ou à consommer la totalité des ressources terrestres revient en réalité à décrire précisément les entreprises de la Tech en régime capitaliste. Nous sommes déjà face à des entités intelligentes dont le but est de maximiser l’accaparement d’une chose inutile (de l’argent) en épuisant les ressources de la planète.

Ensuite, l’idée qu’une super intelligence serait aussi stupide et cruelle que le premier capitaliste venu est davantage une projection des PDG de ce monde (connus pour leur manque d’empathie pathologique et leurs traits sociopathiques) qu’une conséquence inévitable de l’acquisition d’une conscience.

Je ne dis pas qu’il est impossible de construire une IA dotée de capacités cognitives supérieures ou égales à l’homme, mais seulement que les IA génératives ne sont pas une voie directe vers cette super intelligence, et qu’un tel outil ne serait pas vraisemblablement conscient ou désireux d’exterminer le genre humain (volontairement ou par accident). Ce sont ces faux prophètes de l’IA qui veulent activement détruire l’humanité pour sauver leur petit monde, comme le résument parfaitement Thibaut Prévost et de nombreux critiques de l’IA.

Mais alors, on laisse l’IA aux Chinois ? (ou pourquoi personne ne gagnera la course à l’IA)

À ce stade nous avons établi que l’IA générative ne permet pas d’arriver plus vite à une IA générale (AGI), ni à une IA consciente ou toute puissante (singularité).

Autrement dit, investir des milliards de dollars dans des data centers destinés à servir les IA génératives tout en refusant de réguler le secteur, laissant les entreprises californiennes agir comme bon leur semble au nom de la course à l’IA, est une aberration. Non seulement ces logiciels sont dangereux et écologiquement désastreux, mais l’idée que cette fuite en avant serait nécessaire pour maintenir notre maigre avance sur la Chine est une vue de l’esprit. Les avances technologiques en matière d'IA ne durent pas, comme l’avait montré l’irruption de l’IA chinoise DeepSeek, qui rivalisait avec les meilleurs modèles d’OpenAI, elle-même désormais dépassé par Google.

Ensuite, la Chine a largement bloqué son marché aux technologies américaines (Google, Facebook, OpenAI, Amazon, NVIDIA…) tout en développant ses propres géants et produits phares (Baidu, Alibaba, Huawei, TikTok, DeepSeek).

En clair, la Chine va continuer de développer l’IA sans se faire coloniser par la technologie américaine, et les États-Unis vont continuer d’empêcher la Tech chinoise de s’exporter sur leur territoire. Seule l’Europe accepte d’être numériquement colonisée sans condition. Quant à la France, son secteur technologique est pratiquement entièrement lié à la Silicon Valley. Rappelons que Mistral, le champion français, a été créé par d’anciens employés de Facebook avec l’aide des capital-risqueurs de San Francisco, avant de signer un partenariat avec Microsoft…

Si investir dans l’IA de pointe peut présenter des intérêts stratégiques et touche aux questions de souveraineté, l’IA générative est au mieux une distraction, au pire un gaspillage de ressources.

La haine de ChatGPT est juste et saine

Il y aurait encore beaucoup à dire et quelques autres mythes à debunker. Retenons un point principal : les IA génératives entrainent des risques vertigineux pour la société, tout en produisant des torrents de boue (IA slop) pour un cout énergétique délirant. La question n’est pas tant de savoir ce qu’ils seront capables de faire à un horizon mal défini. Mais de prendre conscience que dans le meilleur des cas (le scénario rêvé par les pontes de la Silicon Valley), ils finiront pour produire du chômage de masse et une forte addiction pour enrichir exclusivement les entreprises qui les produisent. En attendant, on brûle et pille des ressources considérables pour produire des chatbots érotiques et des vidéos inutiles.

Il est grand temps de vouer à tous ceux qui participent à la promotion et la diffusion de cette technologie un mépris et un rejet total. Comme à cette ministre française rendant hommage aux poilus de la guerre 14-18 non pas avec une image d’archive de l’INA, mais avec un visuel créé par une IA qui représentait une carte de France avec deux Bretagne !

Sur ce, merci de m’avoir lu et joyeux Noël à tous !

Merci, un article bien documenté qui fait du bien

Ca me déprime de voir à quel point l'usage des LLM s'est généralisé (surtout que les gens sont pourtant souvent très conscients de tous les problemes que posent les LLM mais décident d'en avoir rien à carer quand meme, même à gauche... on ira loin avec une inconséquence politique pareille - et ne commencons meme pas à parler des liens entre ces entreprises et le militaire...)