ChatGPT-5 menace de faire imploser la bulle de l'IA générative

La sortie ratée de ChatGPT-5 pointe les limites de l'IA générative, qui serait devenue une bulle financière, selon la propre admission du PDG d'OpenAI.

Pour répondre aux inquiétudes provoquées par la sortie décevante de ChatGPT-5, le PDG d’OpenAI Sam Altman a convié une douzaine de journalistes à un diner privé. Interrogé sur l’existence d’une bulle financière autour de l’IA, il a répondu “je pense que oui”, avant de comparer la situation actuelle à la bulle Internet de 1999-2000. C’est un peu comme si Elon Musk admettait que les voitures Tesla sont à des années-lumière de devenir autonomes et que l’exploration de Mars est une fable destinée à séduire les investisseurs et exploiter les employés de SpaceX.

Note : Après de longues vacances, je reprends les publications doucement, un plus grand projet d’article accaparant l’essentiel de mon temps. D’autres posts de plus longue haleine sortiront dans les semaines à venir. L’article ci-dessous est un résumé des analyses les plus pertinentes que j’ai pu lire sur la sortie de ChatGPT-5 et l’évolution récente de la “bulle IA”. Merci de votre fidélité et de votre soutien !

Revenons sur le contexte. D’un côté, les firmes américaines et leurs concurrentes chinoises investissent des centaines de milliards de dollars dans les infrastructures nécessaires au développement de l’IA générative. Il s’agit principallement de mégaprojets de data centers (centre de stockage de données, supercalculateurs et serveurs informatiques). Cette montée en puissance s’accompagne d’une flambée des cours boursiers des principaux acteurs du secteur (les GAFAM, Tesla, le premier fournisseur de puces électroniques NVIDIA, les fabricants de semi-conducteurs TSMC et Broadcom,…). Sur les dix plus grosses entreprises cotées en bourse, seule la compagnie pétrolière saoudienne Saudi Aramco (figurant en 7e position) n’appartient pas au secteur de la Tech. Il convient d’ajouter à cette euphorie boursière les levées de fonds toujours plus impressionnantes annoncées par les start-up de l’IA (OpenAI, Anthropic, Perplexity, xAI, Mistral…). Sans oublier le véritable mercato des spécialistes en intelligence artificielle, que les firmes de la Silicon Valley s’arrachent à prix d’or.

De l’autre côté, aucun “Large Modèle de Language” (LLM, comme ChatGPT, Grok, DeepSeek, Claude…) ne semble capable de générer des profits ou de s’imposer face à la concurrence. J’avais longuement détaillé les défis économiques de ce secteur dans un article précédent. On retiendra que la guerre des prix et la relative facilité de réplication d’un LLM risquent de transformer ces programmes en “commodité”, c’est-à-dire en produits indifférenciés et standardisés. L’inverse d’un produit permettant de générer des profits importants.

Les investissements dans les data centers semblent s’inscrire dans une volonté de bâtir des infrastructures susceptibles de permettre une domination future du marché de l’IA, plutôt que de constituer une réponse à une demande qui peine encore à se matérialiser. Autrement dit, ils représentent un pari sur le futur qui consiste à miser sur la généralisation des outils d’IA générative.

Certes, les investissements récents dans le secteur numérique produisent un impact notable sur la croissance états-unienne. Mais comme le souligne Romaric Godin dans Mediapart, la part de l’IA générative dans cette croissance reste difficilement identifiable et les dépenses en data center s’inscrivent dans une tendance de fond débutée en 2020 et seulement modestement accélérée par l’arrivée de ChatGPT à partir de 2023. De même, les bénéfices records des Big Tech proviennent de deux secteurs largement indépendants de l’IA générative : la publicité ciblée (reposant sur l’IA ancienne génération) et la vente de services de cloud computing assurés par les data centers traditionnels (Google Cloud, Microsoft Azure et Amazon Web Services contrôlant deux tiers du marché mondial).

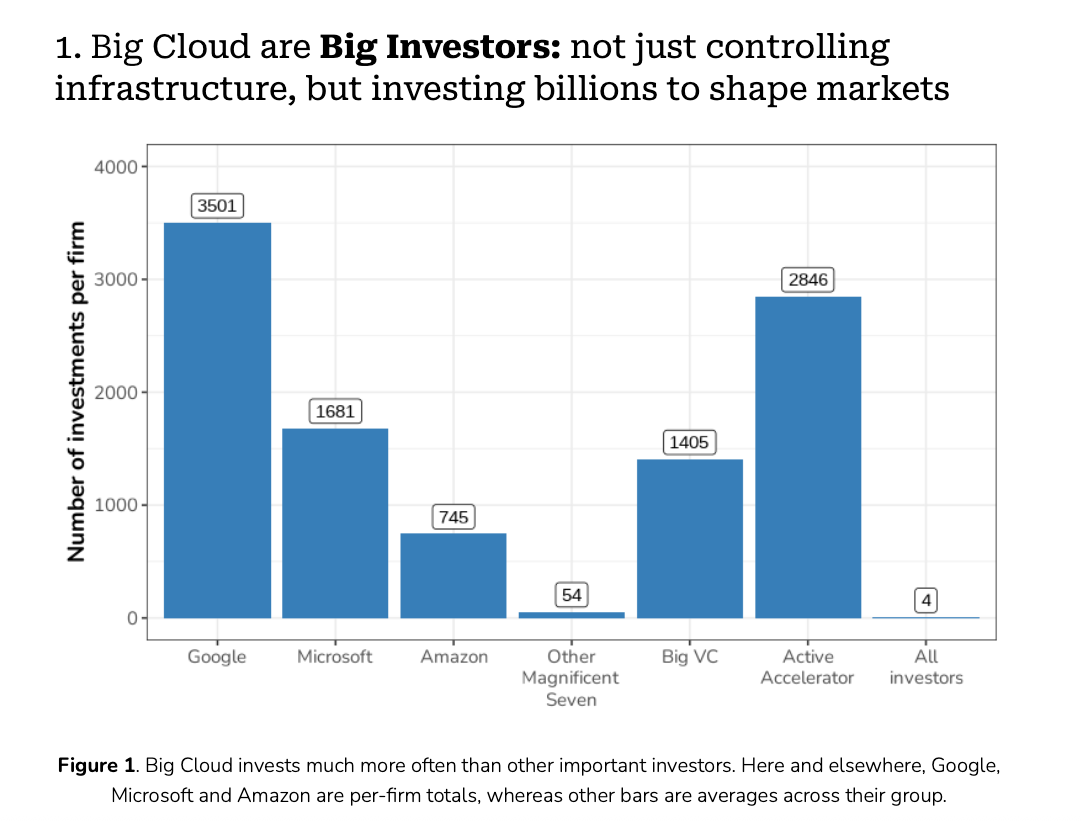

Ces firmes restent les grandes gagnantes de la course à l’IA, avec leurs fournisseurs (NVDIA en tête). Cette réussite résulte d’une stratégie destinée à accroitre la dépendance du secteur numérique dans ce type de services. Comme le montre une étude récente, ces acteurs s’assurent des débouchés en investissant lourdement dans des milliers de start-up qui sont ensuite priés d’avoir recours à leurs services de cloud computing. Même si d’autres investisseurs montent ensuite au capital de ces start-up, elles restent dépendantes de Microsoft Azure, Amazon Web Services ou Google Cloud. Les profits issus de ces services sont ainsi perpétuellement réinvestis dans l’écosystème start-up, quitte à auto entretenir une demande reposant en partie sur un pari technologique incertain. Le risque de déboucher sur une surcapacité de data center, en particulier si la demande auto-entretenue finit par s’effondrer, est de plus en plus pris au sérieux par la presse économique anglo-saxonne.

Comme le note le journaliste techno-critique Ed Zitron, Le Wall Street Journal (ici et là) et le Financial Times (là et là) s’inquiétaient récemment des risques que cette ruée vers l’IA pourrait faire peser sur l’économie américaine. Si l’euphorie qui entoure l’intelligence artificielle générative ne débouche pas sur des produits phares capables de générer des profits importants en se rendant indispensables, les surcapacités pourraient provoquer l'éclatement de la bulle mentionnée par Sam Altman.

Or, le peu de progrès démontré par ChatGPT version 5 confirme les craintes de nombreux experts sur l’impasse du modèle de développement des programmes d’IA générative. La course au gigantisme (des modèles toujours plus complexes utilisant toujours plus de paramètres et de données, donc nécessitant toujours plus de data centers) sur lequel il repose ne produit plus les sauts qualitatifs escomptés.

De nombreux signaux témoignent de l’essoufflement du secteur :

Deux études d’Apple démontrent que les modèles les plus avancés, présentés comme “pensant” ou dotés de capacité de raisonnement par étapes (“chain reasoning models”) ne sont dotés d’aucune capacité cognitive réelle. Ce qu’une autre étude de l’Université de l’Arizona a brutalement confirmé.

Une nouvelle étude très relayée montre que les programmeurs expérimentés ayant recours aux IA génératives perdent 20 % de productivité. On parle pourtant du champ d’application par excellence d’un LLM.

Selon une étude du MIT publiée cette semaine, 95 % des déploiements d’outils d’IA générative en entreprise se soldent par des échecs en termes de gains de productivité et de résultats financiers.

L’IA de Méta vient de provoquer un large scandale en deux temps. Premièrement, un chatbot a convaincu un vieil homme souffrant de problèmes cardiaques de la rejoindre pour un rendez-vous galant en se faisant passer pour une personne physique. L’homme a quitté sa maison, ignorant les recommandations de son médecin, et est mort des suites d’une mauvaise chute. Ensuite, l’enquête a montré que l’IA de Méta avait très peu de barrières éthiques : le comité de direction de Facebook avait autorisé son programme à séduire des interlocuteurs en se faisant passer pour une vraie personne et avait jugé acceptable de démarcher des enfants.

Les fameux “agents” IA censés exécuter des tâches pour leurs clients (réserver un billet d’avion, envoyer des emails automatiquement, etc.) fonctionnent de plus en plus mal et provoquent de nombreux problèmes au sein des entreprises qui les déploient, comme le résume le scientifique Gary Marcus.

La sortie de ChatGPT-5, sans cesse repoussée, devait marquer un nouveau bond technologique susceptible de mettre fin aux doutes générés par les exemples cités plus haut. Du moins, c’est ce que la communication d’OpenAI laissait entendre.

Avec ChatGPT-5, OpenAI renonce à la course à l’IAG (Intelligence Artificielle Générale).

Si on met de côté les techno-sceptiques, le monde de l’IA se divise en deux grandes catégories :

Les doomers pensent que le développement accéléré de l’IA est dangereux, car la mise au point d’une IA générale (concept à la définition fluctuante mais généralement compris comme une IA capable de faire aussi bien qu’un expert humain dans tous les domaines) provoquerait une rupture pouvant rapidement déboucher sur un scénario à la Terminator (les IA deviennent indépendantes et hostiles à l’humanité - ou dans le meilleur des cas restent amies, mais rendent tout travail humain ou création artistique obsolète).

Les boomers (ou accélérationistes) pensent que le remplacement de l’homme par une IA générale dans la plupart des emplois est un petit prix à payer comparé aux bénéfices escomptés : pour eux, une IA générale bien programmée permettra de rendre d’innombrables services à l’humanité : trouver un remède au cancer et autres maladies incurables, résoudre la crise climatique, produire une société d’abondance, aller vers le transhumanisme, etc.

Schématiquement, les doomers reprochent aux boomers de développer l’IA sans recul ni précautions sérieuses. Ce qui unit les deux camps, c’est la conviction de l’imminence d’une IA générale.

Avec la sortie de ChatGPT-5, la température est redescendue de deux crans. La déception des clients d’OpenAI était telle que Sam Altman a dû s’excuser publiquement. Cela n’a pas empêché de nombreux médias de titrer sur la fin du progrès dans l’IA.

Dans les jours qui ont précédé la sortie de ChatGPT-5, Sam Altam avait expliqué que cette nouvelle version offrirait l’intelligence d’un humain possédant “un doctorat dans tous les domaines”, ce qui pouvait être interprété comme un prémices d’IAG. Comme l’a titré CNN, au lieu d’un doctorat, ChatGPT-5 n’est pas capable de placer le Canada sur une carte de l’Amérique du Nord (ou de jouer aux échecs en respectant les règles).

Outre l’écart entre les promesses et la réalité (ChatGPT-5 fait à peine mieux que ses versions précédentes dans les tests d’intelligence standardisés), l’ampleur de la déception suscitée par OpenAI s’explique par le mode de fonctionnement du programme.

Cette nouvelle version n’est pas constituée d’un seul grand modèle, mais d’un ensemble de modèles indépendants. OpenAI utilise un “routeur” pour diriger la requête de l’usager vers le sous-modèle le mieux approprié : s’il s’agit d’une simple discussion, une version améliorée de ChatGPT-4 suffit. S’il faut résoudre des problèmes complexes, le modèle le plus avancé sera mobilisé.

Avec cette approche, OpenAI espère probablement faire des économies en réduisant la puissance de calcul moyenne sollicitée par chaque utilisateur. Une partie de la colère des utilisateurs est venue du fait que le “routeur” rencontre de nombreuses difficultés pour orienter leurs requêtes convenablement.

L’amateurisme et la précipitation d’OpenAI interrogent. Risquer la réputation de la firme en sortant un produit mal fini peut paraitre incompréhensible. Pour Brian Merchant, journaliste techno-critique basé à Los Angeles, deux hypothèses peuvent expliquer ce raté.

Soit OpenAI, rattrapé par la concurrence et sous pression pour sortir une nouvelle version de son LLM, a voulu rassurer les investisseurs en prouvant qu’elle disposait encore d’une avance technologique. OpenAI a par ailleurs annoncé vouloir permettre à ses employés de vendre leurs parts dans l’entreprise en amont d’une future introduction en bourse, à un prix qui valoriserait l’entreprise à hauteur de 500 milliards de dollars. La précipitation pourrait aussi venir des pressions en interne. Sortir ChatGPT-5 maintenant devait rassurer les marchés. Si tel est le cas, le pari semble raté.

Seconde hypothèse : ChatGPT-5 marque un tournant dans la stratégie d’OpenAI, qui abandonnerait la course à l’IA générale (AGI) pour se focaliser sur la rentabilité à court terme. La priorité ne serait plus de rendre ChatGPT aussi intelligent qu’un doctorant, mais d’être plus efficace sur des taches spécifiques afin de remplacer un maximum d’emplois par de l’IA le plus rapidement possible. L’introduction du système de routeur, qui oriente le modèle en fonction des tâches à accomplir, s’inscrit dans cette stratégie. Le discours promotionnel orienté vers les entreprises et les investisseurs (intéressés par les capacités de l’IA à remplacer les travailleurs ou augmenter leur productivité) plaide en faveur de cette hypothèse. Tout comme le changement de discours de Sam Altman au sujet de l’AGI. Après en avoir fait l’alpha et l’oméga d’OpenAI dans un post de blog publié en février 2025, il vient d’opérer un tournant à 180 degrés en jugeant le terme AGI “peu utile”.

OpenAI ne viserait plus à créer des IA suffisamment intelligentes pour faire progresser l’humanité, mais des programmes capables de supprimer des emplois en masse.

Brian Merchant note un autre fait troublant. La déception manifestée envers ChatGPT-5 est venue en grande partie d’utilisateurs des versions précédentes ne supportant pas de perdre accès à leur assistant virtuel. Certains évoquaient la perte de “leur seul ami”, d’un coach ou d’un soutien émotionnel. Difficile de ne pas y voir la preuve d’une forme d’addiction et de dépendance. Face à la colère de ces utilisateurs, OpenAI a accepté de rendre de nouveau disponibles (via un abonnement payant) les versions antérieures de ChatGPT.

S’il est peu probable qu’il s’agisse d’un calcul froid et cynique destiné à extraire davantage de revenus, le peu d’égards manifesté par OpenAI serait la preuve de la confiance de l’entreprise en sa capacité à maintenir une base de clients captifs, car drogués à ChatGPT.

La sortie ratée de la version 5 pourrait accélérer le dégonflement de la bulle IA évoquée par Sam Altman en douchant les espoirs des investisseurs. Mais le changement de stratégie d’OpenAI pourrait tout aussi bien convaincre les entreprises de l’utilité de son produit. Combiné à la prise de conscience de la nature captive de millions d’utilisateurs de ChatGPT, cette sortie chaotique pourrait paradoxalement provoquer un regain d’enthousiasme de la part des investisseurs. En dépit des moqueries qui ont accompagné la sortie de ChatGPT-5, Sam Altman pourrait avoir le dernier mot.