Une brève Histoire de la Silicon Valley (2/4)

Second épisode de notre série sur la Silicon Valley. Au programme: la révolution informatique, Jobs et Gates, Internet et le World Wide Web, la bulle.com et le triomphe du Venture Capital.

Bienvenue dans cette “Brève Histoire de la Silicon Valley”, une série en quatre articles pour comprendre comment cette région du monde est devenue le cœur du capitalisme contemporain. D’où vient la Tech et où nous amène-t-elle ? Comment fonctionne l’innovation ? Nous tentons d’explorer ces questions et de nombreuses autres à travers ce long format. Le premier épisode est à découvrir ici. Les suivants seront publiés chaque lundi sur FakeTech.fr.

Pour soutenir mon travail, vous pouvez vous abonner à cette newsletter ici où m’offrir un café là. Sur ce, je vous souhaite une bonne lecture !

* Partie 2 : la révolution numérique n’aura pas lieu *

1) Steve Jobs et Bill Gates : de la contre-culture aux monopoles informatiques (1975-2000)

L’émergence des ordinateurs s’est accompagnée de mouvements de résistance, sabotage et protestation. Initialement caractérisées par de gigantesques unités centrales (“main frame”), les premières machines provoquaient la méfiance du grand public. Elles étaient associées à l’industrie de l’armement, aux grandes entreprises, agences gouvernementales et autres organisations nécessitant le traitement de larges quantités de données. Dans les campus californiens, des bâtiments abritant de tels équipements ont été brulés ou attaqués à la bombe par des étudiants protestant contre le rôle joué par leurs Universités dans le développement d’une technologie associée à la guerre et au contrôle.

En 1974, le romancier Arthur C. Clark explique aux caméras d’ABC News que dans un futur proche, chaque famille disposera d’un petit ordinateur de bureau. Avec la miniaturisation progressive des composants et la chute de leurs prix, l’avènement de la micro-informatique était largement anticipé. Pourtant, IBM et les leaders du secteur n’imaginaient pas de débouchés pour ce type d’usage. En 1969, le visionnaire Gordon Moore (cofondateur d’Intel) avait rejeté un projet de mise au point d’un micro-ordinateur. Le seul usage personnel qu’il envisageait étant le stockage de recettes de cuisine. “Et je n’imaginais pas ma femme cuisiner en consultant un ordinateur”, expliquera-t-il plus tard.

Ce contexte explique pourquoi l’avènement de l’ordinateur personnel a été facilité par des individus ancrés dans la contre-culture hippie des années 1960. Des geeks, hackers et passionnés, parfois adeptes de trips sous acide. Pour eux, l’ordinateur pouvait être un instrument révolutionnaire, émancipateur et démocratique. L’usage de substances psychédéliques, qui avait également fait l’objet de recherches universitaires en Californie, s’inscrivait dans une logique similaire d’augmentation de l’homme et de libération de l’individu.

Dès 1965, une équipe d’étudiants et de chercheurs rejoint le SRI (Stanford Research Institute) pour travailler sur la micro-informatique. Financé par le DARPA (Defense Advanced Research Projects Agency - le programme de recherche du ministère de la Défense), le laboratoire est dirigé par un certain Douglas Engelbart. Diplômé de Berkley et fasciné par l’idée d’augmentation de l’homme par la machine, il a été influencé par les travaux de Joseph Licklider, psychologue au MIT, et les écrits de Venmar Bush, un haut fonctionnaire du ministère de la Défense. Engelbart avait attiré l’attention des décideurs qui le financeront en publiant un rapport sur le potentiel “d’un ordinateur comme outil personnel à l’usage individuel” pour le compte de la NASA. En 1968, au cours de ce qui sera surnommé la “mère de toutes les démos”, Engelbart fait la démonstration des inventions de ses équipes : une souris et une interface graphique permettant de réaliser la première visioconférence, d’envoyer le premier e-mail et d’effectuer du traitement de texte s’affichant directement sur un écran. Xerox débauche une partie de son équipe pour fonder le Xerox PARC à Palo Alto. Situé sur le campus de Stanford, une des missions de ce centre de recherche est le développement d’un ordinateur personnel. L’Alto voit le jour en 1973. Ce premier ordinateur doté d’une souris, d’un clavier et d’une interface graphique permettant de réaliser du traitement de texte reste très onéreux. Xerox refuse de le commercialiser : avec son système de revendeur, ses grands comptes professionnels, ses commerciaux aux salaires mirobolants et ses ouvriers syndiqués, la multinationale n’a pas la capacité organisationnelle pour distribuer un tel produit, dont le coût des composants reste prohibitif.

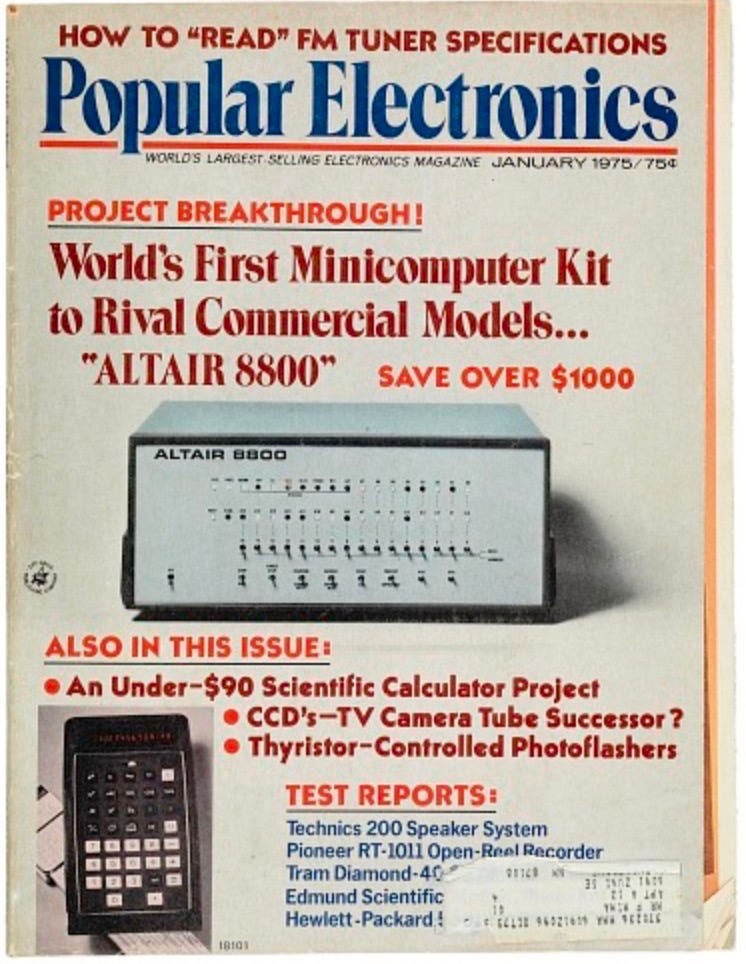

La même année, le Micral devient le premier ordinateur personnel piloté par un microprocesseur à être commercialisé. Il est mis au point par deux ingénieurs français, mais ne sera jamais produit à grande échelle, faute de capitaux. Quelques mois plus tard, MITS, une start-up basée à Albuquerque et spécialisée dans la vente de kits électroniques pour passionnés, sort le premier ordinateur en kit abordable : l’Altair 8800, basée sur le microprocesseur Intel 8800. Le lancement fait la couverture du magazine Popular Electronics. Il est vendu sans logiciel et ne peut pas faire grand-chose, mais suscite un enthousiasme considérable au sein de la communauté de hackers, geeks et passionnés.

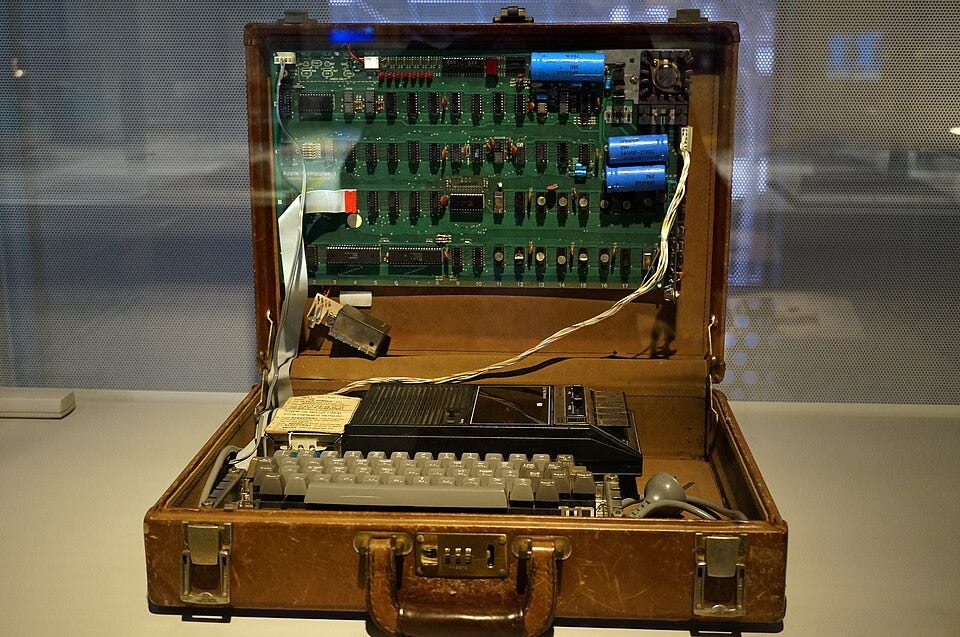

Un dénommé Steve Wozniack assiste à sa démonstration au sein du Homebrew Computer Club, une association de geeks de l’électronique qui se réunissent tous les mois dans un amphithéâtre de Stanford. Le club fonctionne sur le principe du partage et de la collaboration. Sa centaine de membres rassemble des étudiants, jeunes ingénieurs, geeks et activistes. Wozniack travaille chez HP. Après les heures de bureau, il passe ses soirées dans les labos de son employeur pour travailler à son propre projet de micro-ordinateur. Il le termine en 1976 et en fait la démonstration au Homebrew. Bidouilleur génial, “Woz” met au point un kit permettant de connecter un écran à la carte mère et d’afficher les instructions directement. On est à des années-lumière des limitations imposées par l’Altair, sans être aussi avancé que l’Alto, dont le prototype n’a pas été dévoilé au grand public. Woz compte partager librement ses plans avec les membres du Homebrew, mais son ami Steve Jobs le convainc de commercialiser les kits. Wozniak propose d’abord son invention à son employeur, qui refuse poliment de produire l’appareil, jugé trop empli de l’esprit hacker pour rejoindre la gamme HP. Libres de toute obligation, les deux Steve fondent Apple Computer pour commencer la production d’une centaine de kits depuis leur garage à Palo Alto. Pendant que Jobs tente de vendre le concept à des investisseurs, sans succès, Wozniack se lance dans le design d’une version améliorée : l’Apple 2.

Pour l’Apple 1, “j’ai utilisé les meilleurs composants que je pouvais me payer et écrit les bases du programme” expliquera Wozniack. L’Apple 2 a vocation à inclure des logiciels, un boitier et des composants plus puissants. Comme nous l’avons vu, sa mise sur le marché sera rendue possible par l’intervention du capital-risqueur Mike Markkula et de ses réseaux Fairchild/Intel.

Bien qu’un ordinateur concurrent (le Commandor) réalise de meilleures ventes les premières années, Apple va toucher de l’or grâce à un coup de pouce du destin. Une entreprise met au point un logiciel de comptabilité conçu exclusivement pour l’Apple 2 : Visicalc. Cet ancêtre d’Excel est plébiscité par les entreprises, faisant de l’Apple 2 la vache à lait de la firme pendant deux décennies. Ce qui permettra de survivre aux échecs commerciaux induits par l’impétueux Steve Jobs, dont le LISA et le premier Macintosh.

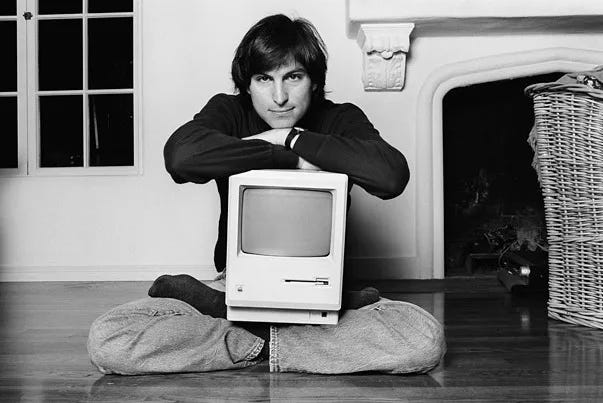

À la fin des années 1970, Apple détient 40 % des parts du marché de l’ordinateur personnel. Xerox investit dans la firme et reçoit Jobs et ses équipes au PARC, où l’entrepreneur assiste à la démonstration de l’Alto. L’interface graphique l’impressionne. Jobs recrute une partie de l’équipe du PARC et débute le développement du LISA, avant de se faire retirer le projet par le conseil d’administration, ses pratiques managériales étant jugées trop toxiques. Il se rabat sur le développement du Macintosh, une version grand public et minimaliste du LISA, dont le concept et le nom lui ont été soufflés par un ingénieur d’Apple. Avec ses obsessions et son perfectionnisme, Jobs retarde le développement et impose des choix de design désastreux : un microprocesseur trop lent et une absence de ventilateur qui expose l’ordinateur à des risques de surchauffe. L’équipe de développement démissionne, en burn-out, peu de temps après sa mise sur le marché.

Propulsé par une campagne de publicité d’ampleur inédite, le Macintosh sort en 1984. Il s’agit du premier micro-ordinateur grand public disposant d’une souris et de l’interface graphique avec laquelle nous sommes tous familiers. Plus besoin d’entrer des lignes de commandes pour effectuer des tâches. Mais entre temps, IBM a sorti son Personal Computer. L’approche du géant de la bureautique diffère radicalement de celle d’Apple. Au lieu de tout faire soit même, IBM se contente d’assembler un kit constitué des meilleurs composants du moment et confie le développement des logiciels à des sous-traitants.

Aidée par sa puissance industrielle et commerciale, l’approche de “Big blue” permet de casser les prix tout en offrant au micro-ordinateur la légitimité qui lui faisait encore défaut dans le monde de l’entreprise et auprès des cadres. Le PC écrase le marché, bien qu’il ne dispose pas des innovations présentes sur le Mac. Ironiquement, IBM n’en tire pas les bénéfices financiers escomptés. D’autres compagnies (dont Compaq, HP, Sun puis Dell) vont « cloner » ce modèle d’assemblage et livrer une guerre des prix, pour le plus grand bonheur des deux principaux sous-traitants rendus incontournables par IBM : Intel (pour le hardware) et Microsoft (pour le software).

Revenons en arrière. Pendant que Wozniack s’émerveillait devant les promesses de l’Altair, Bill Gates et Paul Allen se rendent à Albuquerque pour proposer un système d’exploitation à l’usage de l’Altair, reposant sur le langage BASIC développé par des universitaires. Fort de ce premier contrat, ces deux jeunes étudiants de Harvard fondent Microsoft. Leur programme se diffuse, mais les ventes stagnent. Bill Gates écrit alors au Home Brew Comptuer club une lettre ouverte qui fera date. Il s’y plaint du fait que de nombreuses personnes utilisent le code de Microsoft sans payer de royalties. Pour faire fortune, le futur milliardaire a besoin de vendre des licences, or l’éthos de hacker caractérisant la communauté des passionnés de micro-informatique va à l’encontre d’un modèle basé sur la propriété intellectuelle.

Une chance insolente va permettre à Microsoft d’écraser progressivement le modèle du logiciel libre. La mère de Bill Gates siège au Conseil d’administration d’IBM et l’aide à obtenir le contrat du siècle : la multinationale confie le développement du système d’exploitation de son premier PC à Microsoft, dont le cofondateur s’est taillé une petite notoriété suite à ses frictions avec le Homebrew.

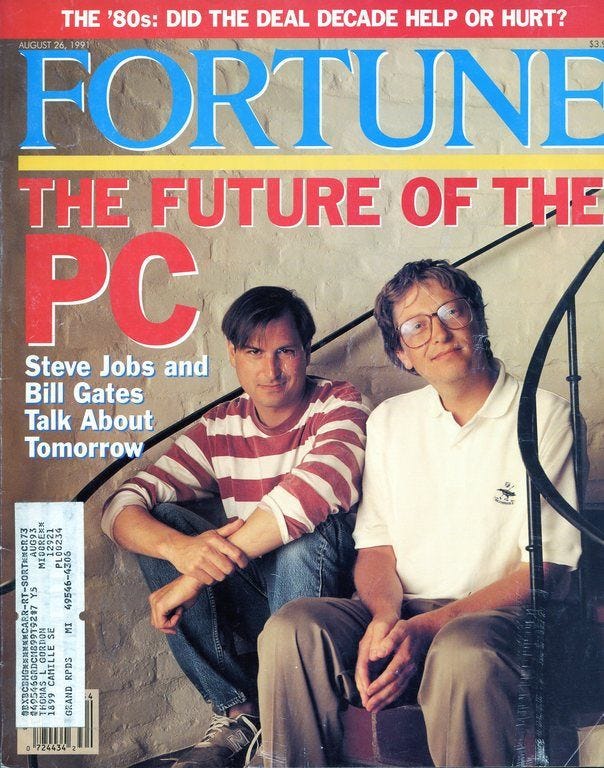

Pour honorer le contrat, Gates rachète QDOS, un système d’exploitation conçu par un ingénieur de Seattle et dont le sigle signifiait “Quick and Dirty Operating System” (Sytème d’exploitation vite fait mal fait). Renommé MSDOS, le programme est livré d’office avec tous les PC. Microsoft va utiliser cette position monopolistique pour écraser la concurrence via différentes tactiques plus ou moins légales. Guerre des prix, copie et vol d’idées, installation de programmes par défaut avec le système d’exploitation DOS… les pratiques iront jusqu’à introduire volontairement des bugs dans ce dernier pour empêcher les logiciels de traitement de textes et les tableurs des entreprises concurrentes de fonctionner convenablement. Le contentieux le plus médiatisé opposera Gates à Steve Jobs. Ce dernier avait confié à Microsoft le développement de certains programmes pour le Macintosh. Il est horrifié lorsque Microsoft sort Windows, un système d’exploitation à l’interface graphique inspiré du Mac et de l’Alto.

Pour le grand public, les années 1980 et 1990 sont ainsi dominées par le conflit entre Apple et Microsoft, repeint en David contre Goliath par le marketing d’Apple. Jobs bénéficie de l’image d’un génie visionnaire, artiste et rebelle, tandis que Gates incarne le nouveau Rockefeller, impitoyable monopoliste dont les produits mal finis sont truffés de bugs.

En réalité, ces deux figures majeures de la Silicon Valley partagent de nombreux points communs. L’un et l’autre sont connus pour leurs comportements exécrables, leurs accès de colère légendaires et leur attitude dénuée d’empathie envers leurs collaborateurs et employés, à la limite de la sociopathie. L’un et l’autre tentent de construire des monopoles (Jobs y parviendra dans les années 2000-2010, avec l’iPod, l’iPad et l’iPhone). Surtout, l’un et l’autre ont comme caractéristique de s’être trouvés au bon moment au bon endroit. Jobs et Wozniack ont grandi à Palo Alto, au cœur de la révolution informatique. Depuis les laboratoires d’HP, Woz a pu avoir accès aux meilleurs outils pour peaufiner son projet d’ordinateur. Le HomeBrew de Stanford a également été un lieu d’échanges et de rencontres indispensables au développement du projet Apple.

De son côté, Gates a étudié dans un des premiers lycées privés du pays doté d’un ordinateur, sur lequel il a pu apprendre très tôt les bases de la programmation en BASIC, avant d’être admis à Harvard et de bénéficier des réseaux de ses parents pour signer un contrat déterminant avec IBM.

Enfin, Jobs comme Gates ont permis à la Silicon Valley de tourner la page du keynésianisme financé par les dépenses militaires et étatiques pour entrer dans l’ère néolibérale et la consommation numérique de masse. Si Xerox a ouvert ses portes à Apple, c’est parce qu’elle comptait sur la start-up pour commercialiser son Alto, une chose qu’elle n’avait pas les capacités organisationnelles de faire elle-même. De même que Gates a joué un rôle majeur pour écraser le modèle du logiciel libre, Apple a innové par ses circuits de production. Les Macs étaient assemblés en Californie par un vaste réseau d’ateliers et usines employant des immigrés, souvent asiatiques, sous-payés, clandestins et non syndiqués. En 1984, Jobs reçoit Danielle Mitterrand, épouse du président français, dans l’usine dernier cri du Macintosh. Il s’agace des “préoccupations” de la première dame, qui l’interroge sur les conditions de travail des ouvriers, alors que lui vante les bienfaits de l’automatisation et du juste à temps pour réduire les coûts de main-d’œuvre.

Encore davantage que Gates, le PDG d’Apple est passé maître dans l’art de surexploiter les ingénieurs californiens à coup de semaine de 80 heures et de weekend marathon, en offrant des stock-options et le sentiment de “changer le monde” en guise de motivation. Ces “qualités” ne suffisent pas à faire le succès d’Apple, qui ne dépasse pas les 8% de part de marché lorsque la firme sort l’iPod, produit qui va lui permettre d’assoir sa domination.

Le concept du baladeur mp3 ne vient pas de Steve Jobs. Dès 1979, l’inventeur britannique Ken Kramer construit et brevète un prototype dont le design ressemble à s’y méprendre à l’iPod. Mais à l’époque, le prix des composants demeure prohibitif et leur puissance insuffisante. Le brevet expire en 1988. Comme avec l’Alto, il est encore trop tôt pour commercialiser l’idée. En 2000, Apple achète un concept de baladeur numérique développé par un ingénieur américain, Tony Faden, qui rejoint la firme avec pour mission de concevoir l’iPod. Le succès permet de lancer une gamme de produits (iPad puis iPhone) qui va enfin fournir à Apple une position monopolistique. Encore faut-il produire ces appareils en masse et à bas coût. Jobs recrute Tim Cook, logisticien passé par IBM et Compaq. Nommé responsable de production, il ferme les usines et entrepôts américains, délocalise en Chine, améliore la production en flux tendu et généralise la sous-traitance avec l’aide du spécialiste taiwanais Foxconn. Une vague de suicides provoqués par les conditions inhumaines imposées aux ouvriers pousse le sous-traitant d’Apple à installer des filets de sécurité pour empêcher les employés de se défenestrer. La presse relaie timidement cette face cachée du succès d’Apple, sans que les clients de la pomme se détournent de ses produits.

Si l’avènement de la micro-informatique était inévitable, la Silicon Valley a joué un rôle moteur en imposant un modèle parmi d’autres possibles. Il s’inscrit dans la contre-révolution néolibérale en reposant sur la sacro-sainte propriété intellectuelle, la délocalisation des usines et l’exploitation des ingénieurs. Des tendances qui allaient exploser avec l’arrivée d’internet et la privatisation de nos données. Car plus l’ordinateur s’imposait comme un outil incontournable, plus l’intérêt de connecter ces objets entre eux devenait évident.

2. De l’ARPANET au World Wide Web : vers la privatisation des communs

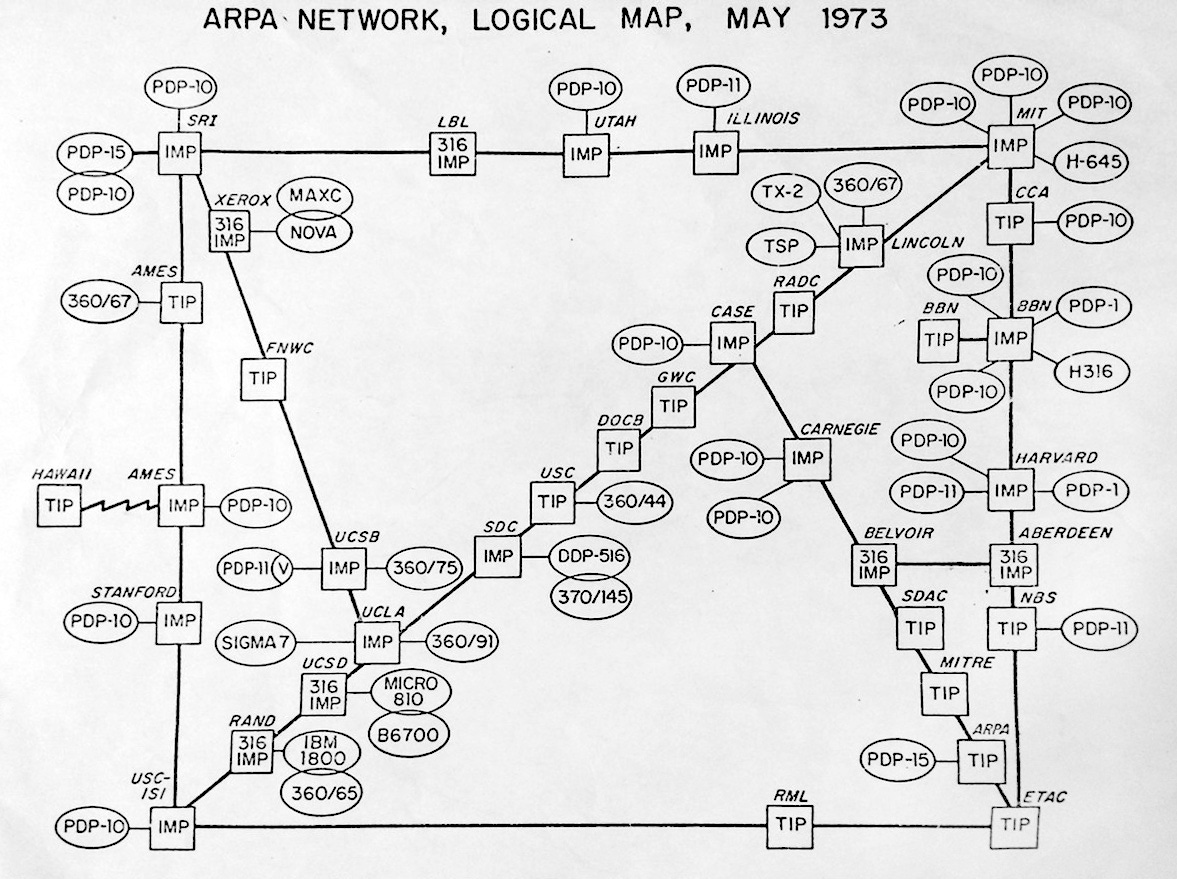

L’avènement d’internet constitue un exemple chimiquement pur des mécanismes socio-économiques à l’origine des révolutions technologiques ayant fait la gloire de la Silicon Valley. À la fin des années 1950, plusieurs équipes de chercheurs mettent au point un système de communication par le réseau téléphonique, en convertissant des signaux numériques en pulsions sonores (et inversement) à l’aide d’un modulateur - démodulateur, le fameux Modem. La seconde innovation cruciale consiste à mettre au point un mode de transmission des données par commutation de paquets, une rupture avec le système employé en téléphonie. Elle permet de stabiliser le réseau et de connecter de multiples terminaux entre eux. En 1965, deux équipes de chercheurs mettent au point cette invention indépendamment : Donald Davies, au National Physic Laboratory anglais (NPL) et Paul Baran à la RAND Corporation (un des plus gros consultants employés par l’armée américaine) avec l’aide de Leonard Kleinrock, du MIT. Des premiers réseaux voient le jour, dont l’ARPANET, qui connecte les universités de Stanford et UCLA dès 1968, puis 23 centres en 1971.

Son développement résulte de la création du “DARPA”, ce programme d’investissement public dans la recherche rattaché au ministère de la Défense. Ce département nait des suites du “moment Spoutnik” qui provoque une panique chez les dirigeants américains inquiets d’un potentiel retard technologique sur l’URSS. Le DARPA implante de nombreux superordinateurs dans les différentes universités américaines. La nécessité de les mettre en réseau pour permettre le partage de temps de calcul entre les centres de recherche serait le principal élément motivant les investissements dans la recherche et l’infrastructure qui accouche d’ARPANET, plutôt que l’idée de construire un réseau de communication décentralisé susceptible de résister à une attaque nucléaire.

Le réseau s’étend bientôt en Europe et se connecte à d’autres nœuds, dont un situé en Angleterre au NPL, un second en Norvège et un troisième en France, où le réseau Cyclade est mis au point par les équipes de Louis Pouzin. Ce dernier collabore étroitement avec les équipes d’ARPANET basées à l’université UCLA, dont le chercheur de Stanford Vincent Cerf. Cyclade perfectionne les protocoles de transmission de données et joue un rôle instrumental pour le bond technologique suivant : l’établissement d’un protocole pour mettre en relation les différents réseaux émergents. Baptisés Transmission Control Protocol et Internet Protocol (TCP/IP) ce système permet à chaque ordinateur de parler le même langage. Le TCP évite que les données transmises se perdent sur le réseau ou produisent des doublons, notamment via l’implémentation d’adresses numériques uniques (les fameuses adresses IP) assignées à chaque appareil. Pour faire fonctionner ce système, un nouveau type d’ordinateur appelé routeur fait son apparition. L’adoption du TCP/IP par ARPANET, en 1983, marque le début de l’International Network, abrégé en “inter-net”.

Dès 1981, la National Science Foundation (NSF), un organisme gouvernemental américain, fonde le réseau CSNET (Computer Science Network). Il doit permettre aux universités et institutions publiques de se raccorder au réseau ARPANET. En 1985, CSNET devient NSFNET, véritable colonne vertébrale du net. Des investissements colossaux permettent de mettre en place ce réseau reposant sur des millions de kilomètres de câbles et autres infrastructures électroniques majeures.

Les financements de la puissance publique permettent de poursuivre les innovations. En 1983, Elizabeth Feinler met au point, avec ses équipes du SRI, un annuaire permettant de convertir les adresses IP des ordinateurs connectés à ARPANET en simple nom de domaine. Feinler les classes en catégories en fonction des usages : .gov, .net, .org, .com… Un chercheur de la University of Southern California complète ce schéma en proposant un système décentralisé d’attribution des noms de domaines : le Domain Naming System ou DNS, encore utilisé aujourd’hui.

Malgré ces avancées, le gouvernement américain n’uniformise pas suffisamment rapidement le protocole TCP/IP. Dès les années 1980, d’autres protocoles et réseaux émergent de Stanford et du PARC. Ce qui permet à des start-up californiennes de capitaliser sur cette jungle pour mettre au point des terminaux permettant de connecter les différents protocoles entre eux. C’est le cas de 3Com, Cisco Systems puis de Sun Microsystems pour la partie “hardware”. Pour le software, d’autres acteurs émergent. Le jeune et flamboyant Larry Ellison (actuel seconde fortune mondiale) et deux collègues de la société Ampex sont mandatés par la CIA pour bâtir une base de données capable d’intégrer différents systèmes. Ils s’unissent pour fonder Oracle Systems, reprenant le nom du projet Oracle que leur avait confié la CIA. La société continue de croitre grâce aux contrats de l’agence de renseignement américaine, dont les ingénieurs aident à résoudre les bugs des premiers produits. Un membre de la CIA concèdera : “on a acheté ce projet tout en sachant qu’il ne fonctionnerait pas, nous achetions avant tout une idée”. Après plusieurs années, Oracle parvient à finaliser un produit fonctionnel et, avec l’aide du capital-risqueur Don Valentine et sa firme Sequoia Capital, réalise une entrée en bourse tonitruante. En 1999, un protégé d’Ellison nommé Mark Benioff lancera Salesforce, une société spécialisée dans les logiciels de marketing destinés à l’usage des entreprises. Elle possède désormais le plus grand gratte-ciel de San Franscico, où se situe son siège social.

Mais c’est du CERN, institution publique située en Suisse, que provient la dernière grande innovation ayant jeté les bases de l’internet moderne. Trouver et échanger des documents sur le réseau restait une tâche ardue sans connaitre leur localisation précise (adresse IP, nom du dossier, etc.). Tim Berners-Lee, un physicien et informaticien anglais, met au point un système permettant d’afficher les données sur des pages et de les télécharger via des liens hypertextes. Le système repose sur trois innovations : la création d’adresses web (URL), d’un protocole d’échange de données (HTTP ou Hyper Text Transfer Protocol) et un langage de programmation (HTML). Ce système est baptisé le World Wide Web (www) et est accessible via un programme nommé navigateur web. Opérationnel dès 1991, il est versé dans le domaine public en 1993. En parallèle, la NSF privatise le réseau NSFNET, de plus en plus encombré par l’explosion de la demande du secteur privé. Si bien qu’en 1993, l’internet devient totalement ouvert au grand public et aux entreprises. Un système conçu avec la recherche et l’argent publics va provoquer une nouvelle ruée vers l’or.

3. Netscape et le nouveau paradigme de la bulle.com

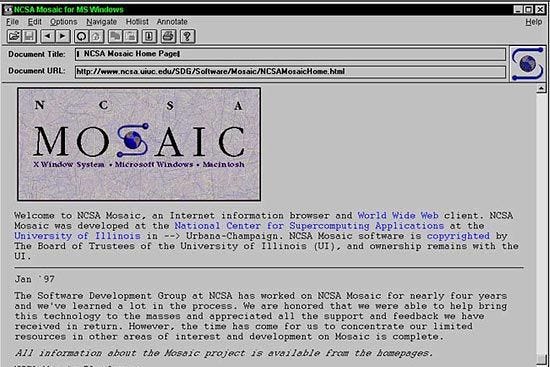

Toujours en 1993, une équipe d’étudiants-chercheurs de l’université de l’Illinois emmenée par un certain Marc Andreessen met au point un nouveau navigateur web baptisé Mosaic. Réalisé à partir des travaux de Tim Berners-Lee, le programme permet d’afficher textes, images et vidéos dans la même fenêtre via une interface grand public. Il est diffusé gratuitement sous licence par l’Université puis rapidement adopté dans le monde de l’éducation et de la recherche. Son diplôme d’ingénieur informatique en poche, Marc Andreessen est approché par Jim Clark, un entrepreneur de la Silicon Valley et ancien professeur d’informatique à Stanford. Avec ses réseaux, Clark est en mesure de financer le lancement d’une nouvelle entreprise qui reprend le nom de Mosaic pour commercialiser le navigateur. Suite aux plaintes de l’Université d’Illinois, ils rebaptisent leurs start-up “Netscape”. Ils mettent rapidement et gratuitement sur le marché leur “Navigator”, premier navigateur web grand public. La diffusion par bouche-à-oreille et via disquette génère un franc succès, mais des revenus insuffisants pour couvrir les frais de développement. Si les utilisateurs sont encouragés à faire un don et les entreprises sollicitées pour payer une licence, peu s’y résolvent.

Bien que la viabilité économique de Netscape restait plus qu’incertaine, le succès immédiat de son Navigator conduit à une introduction en bourse dès 1996. L’action s’arrache à prix d’or et permet à Jim Clark d’empocher plus de 100 millions de dollars. Un nouveau paradigme ébranle la Silicon Valley : pour faire fortune, il n’est plus nécessaire de dégager du profit ou d’être rentable. Démontrer un taux de croissance exponentiel de vos clients suffit. Même si ces derniers utilisent votre produit gratuitement.

Netscape est rapidement pris pour cible par Microsoft. L’entreprise de Bill Gates copie le navigateur d’Andreessen et installe son “Microsoft Explorer” par défaut sur tous les PC équipés de Windows. Cette concurrence déloyale ruinera la réputation de Gates lors du procès intenté par l’État fédéral américain contre la multinationale pour violation des lois antitrusts. Mais cela ne sauvera pas Netscape, racheté pour 4 milliards de dollars par AOL en 1999.

Andreessen va profiter de sa fortune et de sa réputation pour devenir un capital-risqueur très en vue. En 2009, il s’associe avec Ben Horrowitz pour fonder Andreessen Horrowitz (a16Z), un des principaux fonds d’investissement en capital-risque de la Silicon Valley, qui joue un rôle important dans le ralliement des pontes de la Tech derrière la candidature de Donald Trump en 2024.

Au-delà de l’histoire personnelle d’Andreessen, le succès initial de Netscape sert de modèle à un nouveau schéma d’enrichissement. Avec l’explosion d’internet, d’innombrables entrepreneurs tentent de capitaliser sur la bulle financière qui accompagne la croissance fulgurante du réseau. Il suffit de lancer une entreprise dont le nom se termine par .com pour espérer attirer les investisseurs. Ces premiers millions permettent de mettre au point un semblant de site web dont la croissance des utilisateurs peut suffire à propulser une introduction en bourse miraculeuse, alimentée par les capitaux transitant via Wall Street. Or, à la fin des années 1990, la chute de l’URSS et les dérégulations mises en place par les néolibéraux avaient libéré un flot de capitaux, qu’ils soient américains, européens, asiatiques ou plus spécifiquement issus des nouveaux oligarques originaires de l’ancien bloc de l’est. La Silicon Valley, avec ses taux de croissance délirants, représentait le réceptacle idéal pour cette masse d’argent frais.

L’éclatement de la bulle internet va produire une consolidation du secteur autour des entreprises ayant une activité solide. Des sites de commerce en ligne comme eBay et Amazon et des moteurs de recherche comme Yahoo! sortent renforcés de la crise. Mais les leçons ne sont pas retenues. Pendant cette période d’euphorie, de nombreux entrepreneurs au talent questionnable ont fait fortune via une introduction en bourse fructueuse ou en revendant leur start-up in extrémiste. Parmi cette nouvelle génération de patrons figurent Elon Musk, Peter Thiel, Mark Cuban, les cofondateurs d’Uber Travis Kalanick et Garret Camp ou - exemple encore plus parlant - le cofondateur de Theranos Sunny Balwami. Leur talent ne consiste pas à avoir mis au point des entreprises solides ou un produit remarquable - leurs premières start-up ayant fait faillite ou simplement disparu quelque temps après leur rachat - mais d’avoir enrichi leurs investisseurs. Forts de cette crédibilité et souvent convaincus de leur propre génie, ils vont incarner la nouvelle génération d’entrepreneurs de la Silicon Valley. Avant de revenir sur leur parcours, un détour par les années 2000-2015 s’impose.

Ceci clôt la seconde partie de cette série. La troisième sera en ligne à partir de lundi sur mon site “faketech.fr”. Pour ne pas manquer sa publication, vous pouvez vous abonner gratuitement à cette newsletter. Et pour soutenir mon travail, vous pouvez m’offrir un café.

Pour les lecteurs les plus curieux ou pointilleux (je vous vois !), voici une liste non exhaustive de mes principales sources mobilisées au long de la série :

Anatomie d’une bulle, Dr Thomas Gerbaud, Dr Antoine Gerbaud. 2023

Apocalypse Nerds : Comment les technofascistes ont pris le pouvoir, Nastasia Hadjadji et Olivier Tesquet. Éditions Divergences, 187 pages, 2025.

A City on Mars : Can We Settle Space, Should We Settle Space, and Have We Really Thought This Through?, Kelly and Zach Weinersmith. Penguin Press, 448 pages, 2023.

A People’s History of the United States : 1492–Present, Howard Zinn. Harper Perennial Modern Classics, 784 pages, 2005.

Automation and the Future of Work, Aaron Benanav. Verso Books, 256 pages, 2020

Blood in the Machine, Brian Merchant (substack).

Character Limit : How Elon Musk Destroyed Twitter, Kate Conger et Ryan Mac.

Penguin Press, 430 pages, 2024.Elon Musk, Walter Isaacson. Simon & Schuster, 688 pages, 2023.

Elon Musk : Tesla, SpaceX, and the Quest for a Fantastic Future, Ashlee Vance. HarperCollins, 392 pages, 2015.

Empire of AI : Dreams and Nightmares in Sam Altman’s OpenAI, Karen Hao.

Penguin Press, 496 pages, 2025.En attendant les robots : Enquête sur le travail du clic, Antonio A. Casilli.

Éditions du Seuil, 400 pages, 2019.Le mythe de l’entrepreneur : Défaire l’imaginaire de la Silicon Valley, Anthony Galluzzo.

Éditions La Découverte, 240 pages, 2023.Liftoff : Elon Musk and the Desperate Early Days That Launched SpaceX, Eric Berger.

William Morrow (HarperCollins), 288 pages, 2021.Ludicrous : The Unvarnished Story of Tesla Motors, Edward Niedermeyer.

BenBella Books, 288 pages, 2019.No Crypto : Comment Bitcoin a envoûté la planète, Nastasia Hadjadji.

Éditions Divergences, 220 pages, 2023.Palo Alto : A History of California, Capitalism, and the World, Malcolm Harris.

Little, Brown and Company, 720 pages, 2023.Road to Nowhere : What Silicon Valley Gets Wrong About the Future of Transportation, Paris Marx. Verso Books, 272 pages, 2022.

Steve Jobs, Walter Isaacson. Simon & Schuster, 656 pages, 2011.

Une histoire de la conquête spatiale : Des fusées nazies aux astrocapitalistes du New Space, Irénée Régnauld, Arnaud Saint-Martin. La Fabrique, 316 pages, 2024.

Un taylorisme augmenté - critique de l’intelligence artificielle, Juan Sebastián Carbonell, Éditions Amsterdam, 2025

Zero to One : Notes on Startups, or How to Build the Future, Peter Thiel et Blake Masters. (Penguin Random House), 224 pages, 2014.

Articles de presse divers (Jacobin, Wired, The New York Times…).

Wikipédia, articles de presse cités par Wikipédia.