L'économie de l'IA tourne en rond, bientôt l'implosion ?

Hamster dans sa roue, serpent qui se mort la queue ? Difficile de trouver la métaphore parfaite pour décrire le schéma financier qui gonfle la bulle de l'IA générative et menace la planète.

Dans cet article, nous allons détailler les mécanismes de financement qui alimentent la croissance phénoménale du secteur de l’IA générative, avant de se poser la question de la soutenabilité d’une telle “économie circulaire”.

Avant de rentrer dans le vif du sujet, permettez-moi de remercier les quelques abonnés payants qui soutiennent cette publication. J’encourage ceux qui le peuvent à les rejoindre, soit en s’abonnant à “Fake Tech” pour 5 euros par mois sans engagement, soit en faisant un don unique de 2 euros ou plus via le site “m’offrir un café”. Les abonnés gratuits représentent également une grande source de motivation, n’hésitez pas à partager cette publication autour de vous pour la faire connaitre. Bonne lecture et merci de votre fidélité !

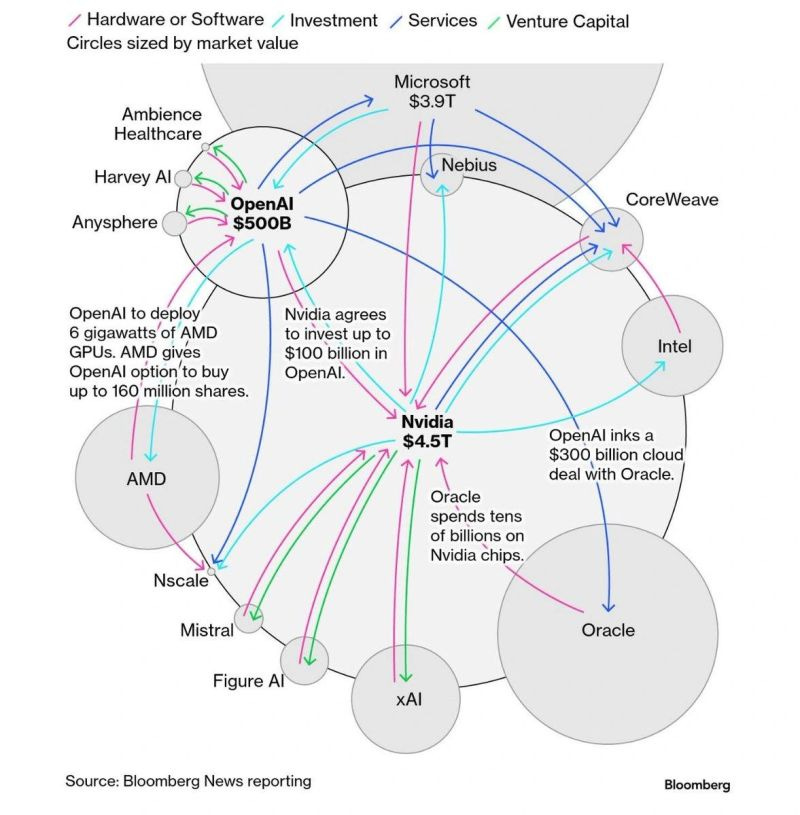

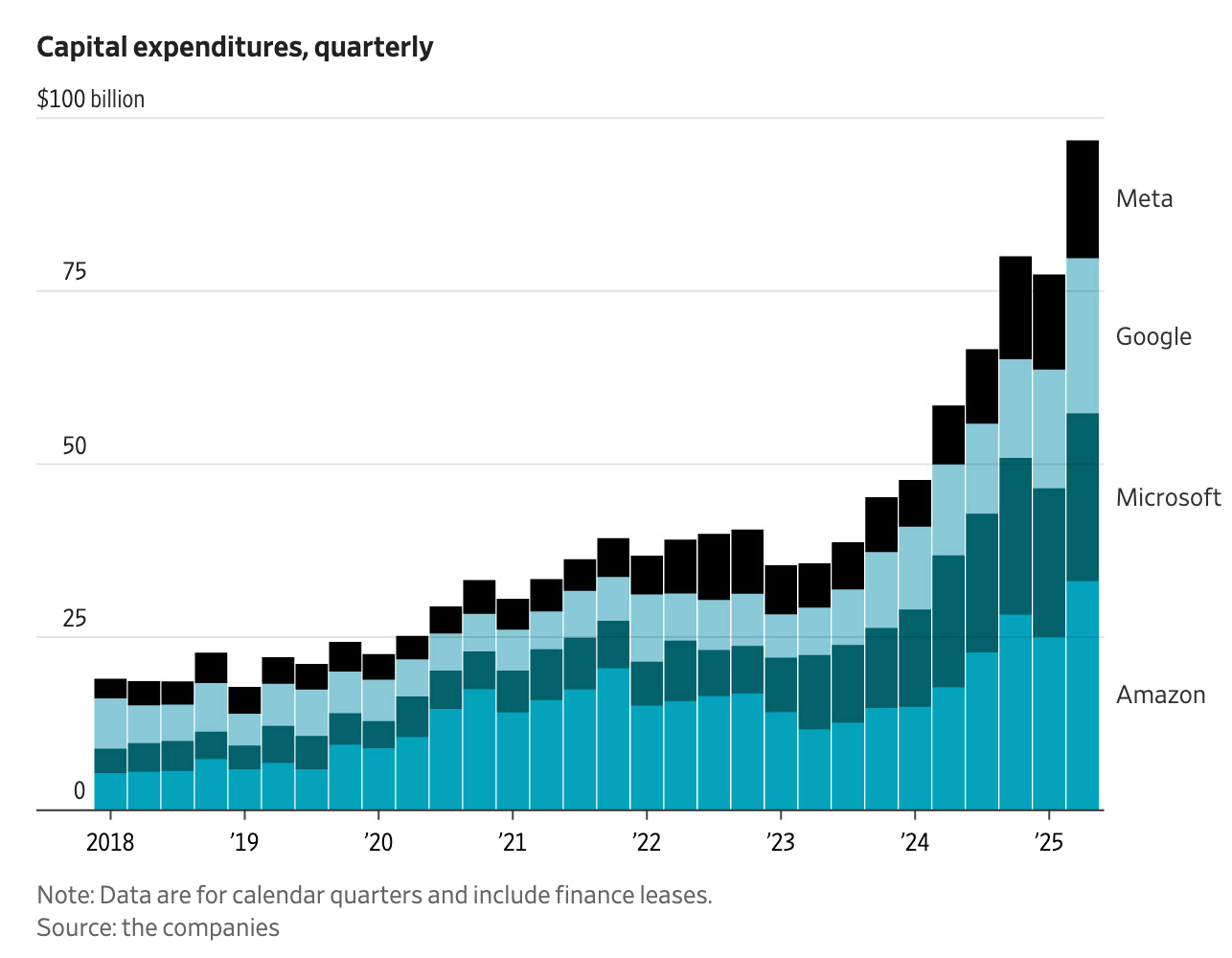

C’est l’histoire d’une bulle qui refuse d’éclater. Elle tire l’ensemble de la croissance économique des États-Unis. La capitalisation boursière des sept entreprises qui en bénéficient le plus représente un gros tiers du S&P 500 (le CAC 40 américain) et 90 % de la hausse de l’indice boursier depuis 2019. La presse financière et les spécialistes alertent de plus en plus fréquemment sur son gonflement. Pourtant, à chaque évènement susceptible d’ébranler la confiance des investisseurs, une nouvelle annonce relance la machine. Un “deal” de 300 milliards entre Open AI et Oracle par ci, un investissement de 100 milliards de Nvidia dans Open AI par là. Ou encore Anthropic signant des accords évalués à plusieurs dizaines de milliards avec Google et Amazon. Le tout sur fond de ruée sur les data centers, construits avec une frénésie sans précédent :

Le montant des investissements dans l’IA générative atteint des niveaux dignes du PIB français. S’il faut différencier les promesses et engagements des sommes effectivement dépensés, les chiffres n’en restent pas moins stratosphériques. Nvidia vient de battre les projections des analystes en rapportant un profit record de 58 milliards de dollars pour le 3e trimestre 2025, soit un bénéfice annualisé comparable au PIB d’un pays comme les Émirats arabes unis ou la Malaisie. Ce qui amène à se poser deux questions :

D’où vient tout cet argent ?

Ne va-t-il pas bientôt en manquer ?

Comprendre l’enjeu du financement de l’IA générative

Pour illustrer le problème, prenons OpenAI. Le leader du secteur de l’IA générative commercialise ChatGPT-5, un agent conversationnel capable de réaliser de nombreuses tâches plus ou moins complexes avec une fiabilité fluctuante. Il repose sur un “Large Modèle de Language” (LLM). À chaque fois qu’un utilisateur lui pose une question, ChatGPT interroge le modèle pour produire une réponse : on parle alors d’inférence. Comme OpenAI reçoit des millions d’inférences par heure et que GPT-5 contient des centaines de milliards de paramètres, l’entreprise doit disposer d’une capacité de calcul titanesque pour répondre à la demande. Sam Altman parle de 30 GW de puissance électrique installée à terme, soit 30 réacteurs nucléaires, 50 grosses centrales à gaz ou la consommation électrique du Royaume-Uni. Pas mal, pour un chatbot dont le principal usage consisterait à offrir un soutien psychologique en se faisant passer pour une sorte d’amant manipulateur.

La puissance de calcul nécessaire provient de puces électroniques spécialisées appelées GPU (Graphics Processing Unit). Elles sont disposées en réseau dans des data centers (“centre de données”) opérés via Internet par un type de service appelé cloud computing.

Les GPU utilisés pour les modèles d’IA générative sont majoritairement produits par Nvidia, leader du marché. Intel et AMD vendent également des GPU de puissance et qualité inférieure. Le service de cloud computing est principalement fourni par quatre entreprises qui contrôlent 89 % du marché (Google Cloud, Amazon Web Services, Microsoft Azure et, dans une moindre mesure, Oracle Cloud). Des acteurs intermédiaires opèrent des data centers ou fournissent des services de cloud computing séparément, comme l’entreprise CoreWeave. Meta (Facebook) opère son propre réseau de data centers en interne, comme quelques autres grosses entreprises.

La chaine de valeur peut être résumée à travers un exemple : Nvidia vend des GPU à un service de cloud computing comme Oracle qui fournit la puissance de calcul à Open AI. Plus OpenAI et ses concurrents produisent des IA gourmandes (type Sora, l’application de génération de vidéos), plus ils ont besoin de capitaux pour construire les data centers abritant les GPU capables de fournir la puissance de calcul nécessaire.

Jusqu’à récemment, OpenAI et ses concurrents obtenaient des capitaux via les schémas de levée de fonds inhérents aux start-up. Des capital-risqueurs investissaient des fonds contre une part de l’entreprise. Cela fonctionne pour récolter des centaines de millions de dollars, devient difficile pour des milliards et virtuellement impossible pour des centaines de milliards. Il n’y a pas assez de capital-risque disponible !

Les autres circuits de financement traditionnels (introduction en bourse et endettement auprès des banques) ne permettent pas de lever des centaines de milliards de dollars aisément, car le chiffre d’affaires du secteur reste dérisoire comparé à ses besoins de financement. En effet, tous les fournisseurs de logiciels d’IA générative perdent de l’argent (les modèles d’IA coutent plus cher à concevoir et à faire fonctionner qu’ils ne rapportent, y compris lorsqu’on augmente le nombre d’utilisateurs, chaque usager supplémentaire générant des inférences en plus, mais moins de dix pour cent d’entre eux souscrivent à une offre payante, qui ne recouvre pas toujours les couts !). OpenAI dépenserait ainsi près d’un milliard de dollars par mois uniquement pour faire face à ses couts d’inférence.

Le scénario d’éclatement de la bulle anticipé par de nombreux observateurs passe par une chute du chiffre d’affaires de Nvdia : si la firme ne parvient plus à vendre ses GPU, c’est qu’OpenAI et consorts n’ont plus d’argent frais à investir, donc ne parviennent plus à faire croitre leur marché et la puissance de leurs IA. Pour éviter que la bulle éclate, il faut continuer à vendre des GPU jusqu’à ce que les profits du secteur permettent d’entretenir la machine indéfiniment.

Résumons :

L’IA générative nécessite des investissements colossaux dans des data centers énergivores pour concevoir puis faire tourner des logiciels commercialisables.

Ces logiciels ne sont pas rentables pour l’instant, car ils coutent plus cher à faire tourner et concevoir qu’ils rapportent (les entreprises hésitent à s’équiper et le grand public utilise très majoritairement les versions gratuites).

Le pour l’instant risque de devenir pour toujours, car il existe de nombreux modèles d’IA générative concurrents et peu ou prou équivalents (Chat GPT, Claude, Grok, Perplexity, DeepSeek, Qwent, Gemini, Llama, Le Chat,…). Et chaque utilisateur supplémentaire augmente le cout de fonctionnement (plus d’inférences) sans augmenter d’autant le chiffre d’affaires. Or, le nombre d’utilisateurs de ChatGPT serait en baisse, comme l’usage de l’IA générative au travail et celui du nombre de programmeurs utilisant les IA génératives pour la programmation.

Les spécialistes s’accordent à dire que la technologie est sur le point d’atteindre une impasse et que l’augmentation de la taille des modèles d’IA ne va pas les rendre plus performants ou économes.

Ces faits expliquent pourquoi la presse économique évoque une bulle. Si ce n’est pas nouveau, OpenAI et consorts continuent d’annoncer des investissements colossaux dans leur modèle de croissance. Alors, d’où vient l’argent ?

La circularité de l’économie de l’IA générative : problème ou solution ?

En observant les annonces du secteur, une image émerge peu à peu. Celle d’un système circulaire où les capitaux transitent d’un acteur de la chaine de valeur à l’autre. Bloomberg et le Wall Street Journal ont commencé à cartographier cette économie. Le résultat donne le tournis :

Au centre de ce genre de diagramme figure Nvdia, leader des fabricants de GPU. L’entreprise occupe une situation équivalente à celle d’un vendeur de pelles en pleine ruée vers l’or. Pour assurer la croissance de ses ventes, elle investit dans les entreprises comme OpenAI. OpenAI va ensuite signer un contrat avec Oracle pour obtenir l’accès à une certaine puissance de calcul, qu’Oracle va fournir en s’équipant en GPU auprès de Nvdia. Ce qui augmente la valeur boursière de chaque entreprise au passage.

Ce type de boucle se manifeste à de multiples niveaux. OpenAI investit également dans les concurrents de Nvidia, AMD et Intel, pour se fournir chez eux. Le “deal” avec AMD est suffisamment fou pour être brièvement détaillé. Comme l’expliquait au Wall Street Journal la directrice financière d’OpenAI, la start-up s’est rendu compte que les actions des entreprises avec lesquelles elle signait des contrats importants avaient tendance à prendre beaucoup de valeur. Pour tirer profit de ce phénomène, OpenAI a commandé pour 6 milliards de dollars de GPU à AMD, contre le droit d’acheter des actions AMD à prix préférentiel. L’annonce du “deal” doit faire gonfler la valeur boursière d’AMD, ce qui permettra à OpenAI de récupérer les 6 milliards en empochant la plus-value sur ses actions. Et ce n’est qu’un exemple parmi tant d’autres.

Les concurrents d’OpenAI (Anthropic, Perplexity, Mistral…) ont recours au même type de circuits de financements. L’entreprise d’Elon Musk, xAI, vient de lever 20 milliards de dollars via un « Special Purpose Vehicle » (SPV, une forme d’entité juridique sur laquelle nous reviendrons plus loin) pour acheter des GPU à Nvdia. Les 20 milliards proviennent d’emprunts garantis par les GPU (pour 12.5 milliards) et de prises de participations dans le SPV (7.5 milliards). Nvidia a injecté 2 milliards de capital sur les 7.5 du SPV. Cette prise de participation renforce le cours de l’action Nvidia et lui assure des débouchés, puisque xAI doit contractuellement utiliser les GPU du SPV pour une durée minimale de 5 ans.

Quant aux autres géants de la Tech comme Meta, Amazon, Microsoft et Google, ils bénéficient du fait d’être présents sur au moins trois secteurs : le cloud computing, les data centers et les logiciels d’IA (via le développement de leurs propres modèles, lorsqu’ils n’intègrent pas aussi ceux d’OpenAI, d’Anthropic ou de concurrents dans leurs produits). Ainsi, Microsoft est à la fois un fournisseur de cloud computing et de data centers via Microsoft Azure, un utilisateur des produits d’OpenAI (ChatGPT est intégré à la version premium de Microsoft Office via l’application Copilot) et un investisseur dans OpenAI.

Un second graphique emprunté au WSJ montre la complexité de ces flux financiers:

Tout cela peut paraitre abstrait, confus et complexe. Pour illustrer la situation, prenons un exemple théorique inspiré de faits réels :

Au XIX siècle, un industriel met au point un nouveau procédé de production d’acier. Pour s’assurer des débouchés, il investit dans les compagnies de chemin de fer qui construisent les premières lignes ferroviaires et les constructeurs de locomotives qui fournissent les trains. L’argent dépensé chez ses clients retourne dans ses poches. Plus les compagnies de chemin de fer ouvrent de nouvelles lignes, plus la demande en locomotives nécessitant de l’acier augmente, plus le cours des actions de chaque acteur du secteur s’envole. Fort de son chiffre d’affaires en hausse, le producteur d’acier peut s’endetter auprès des banques pour continuer d’investir dans les compagnies ferroviaires qui achètent des rails et dans les usines qui produisent des locomotives. Le réseau ferré s’accroit et le nombre de passagers explose. Tout le monde veut placer son argent en achetant des actions ou des titres de dettes émis par les acteurs du secteur, qui peuvent financer de nouvelles lignes… Ce cercle vertueux présente une limite : le nombre de personnes ou marchandises susceptibles de voyager en train. La bulle éclate lorsque les compagnies de chemin de fer ne parviennent plus à écouler leurs billets.

Pour parfaire l’analogie, il faudrait imaginer que de multiples lignes de chemin de fer concurrentes soient installées sur les mêmes trajets, que d’autres lignes relayant des destinations sans intérêts voient le jour et que les compagnies ferroviaires transportent gratuitement les voyageurs de seconde classe, dans l’espoir de les convertir plus tard en clients de première.

Parmi les autres exemples d’économie circulaire, on cite souvent la bulle des télécoms de la fin des années 1990 et le modèle de développement du Japon d’après-guerre, reposant sur les Keiretsu . Ces exemples historiques montrent qu’à la période d’euphorie succède une crise propulsée par l’éclatement de la bulle financière sous-jacente. Si le Japon conserve une partie de ses conglomérats, qu’une part importante du réseau de chemin de fer a survécu aux crises et que les câbles de télécom servent toujours, qu’en sera-t-il de l’IA générative ?

Un serpent qui grossit en se mordant la queue

Le caractère circulaire de ce circuit de financement n’élimine pas la nécessité d’avoir de l’argent qui rentre pour alimenter la boucle. Le secteur n’étant pas rentable, les capitaux soutenant le boom de l’IA proviennent de différentes origines :

Les GAFAMS peuvent financer leurs investissements grâce aux profits records qu’ils accumulent via leurs activités non liées à l’IA (les revenus publicitaires de Google et Facebook, les ventes de logiciels Microsoft, les services de cloud computing classiques d’Amazon, etc.). Ces profits leur confèrent des réserves de liquidités importantes. Combinés à leur faible taux d’endettement, ils jouissent de capacités d’emprunt considérables.

Nvidia agit comme une sorte de banque centrale ou prêteuse en dernier recours pour de nombreuses firmes se finançant sur les marchés via des acteurs appartenants au “shadow banking” (fonds d’investissements, fonds spéculatifs, assurances, produits financiers dérivés…). Ses GPU sont souvent utilisés comme garanties pour les emprunts sur lesquels ils sont adossés, ce qui introduit un risque supplémentaire.

Comme lors de la crise des subprimes de 2008, de nouveaux véhicules financiers ont vu le jour, en particulier les “SPV” évoqués plus haut. Outre xAI, citons Meta, qui a eu recours à une telle structure pour financer un data center de 30 milliards de dollars. L’entreprise de Zuckerberg apporte 6 milliards sous la forme d’une prise de participation et d’un prêt, le reste provient essentiellement de dettes contractées sur les marchés financiers. Une manière d’obtenir toujours plus de capitaux tout en transférant le risque associé aux créances douteuses à des investisseurs de plus en plus éloignés. De plus, Meta n’a pas besoin de faire apparaitre les créances du SPV à son propre bilan comptable, ce qui lui permet de conserver un ratio d’endettement moins élevé.

Le marché boursier secondaire peut aussi, via des mécanismes d’échanges d’actions comme celui mis en place entre AMD et OpenAI, fournir des liquidités. À condition que les investisseurs et petits porteurs suivent… (pour qu’OpenAI récupère sa mise, quelqu’un doit lui racheter les actions AMD à un prix plus élevé).

Tant que la roue tourne et aspire de nouveaux financements, la bulle peut gonfler sans que les entreprises qui utilisent les GPU de Nvidia n’aient besoin d’être rentables. Si elles le deviennent avant que la pompe à capitaux se grippe, le pari d’OpenAI sera gagné. Dans le cas contraire, l’éclatement de la bulle risque d’avoir des conséquences désastreuses, bien au-delà de la Silicon Valley. Ce qui explique pourquoi Sam Altman demande ouvertement à l’État fédéral de devenir un “prêteur en dernier recours”. Ces garanties publiques pourraient prendre la forme d’un plan de sauvetage. Évoquer cette possibilité constitue une manière détournée d’encourager les investisseurs à continuer d’alimenter la bulle, malgré l’accumulation des risques…

Les GPU, maillons faibles d’une chaine opaque

Si le gouvernement américain sauve OpenAI de la faillite et éponge les pertes des institutions financières les plus touchées, le secteur aura réussi un tour de force digne d’un programme communiste : construire une gigantesque infrastructure industrielle à partir de (presque) rien, sans se soucier des questions de rentabilité ou même de finalité, simplement en imprimant de l’argent. Nous n’y sommes pas encore. Différents mécanismes peuvent entrainer une explosion de la bulle, ou à minima, une correction importante des marchés.

En fin de chaine, la question de l’utilité commerciale des IA génératives continue de se poser. Différentes études montrent que le taux de succès du déploiement des IA génératives au sein des entreprises se situe entre 2 et 5 %. Autrement dit, les gains de productivité ne sont pas au rendez-vous, à l’exception de certains secteurs très particuliers. Même OpenAI reste très évasive quant à sa capacité à atteindre la rentabilité à moyen terme.

Le second maillon faible de la chaine de valeur se trouve du côté des data centers. Pour rentabiliser ces investissements, les firmes qui construisent de telles infrastructures doivent louer leur capacité de calcul aux entreprises vendant des IA (comme OpenAI) à un prix suffisamment élevé pour recouvrir leur mise de départ. Or, le tarif de l’heure de GPU baisse fortement depuis quelques mois (de $3.20/h à $2.80/h voir $2.12/h pour les GPU derniers cris, tandis que l’usage des GPU de 2020 n’est facturé que $0.40/h). Et ce n’est pas le seul problème: les GPU ont une durée de vie limitée, tant par leur tendance à être rapidement dépassés par des versions plus puissantes que par le fait qu’une partie d’entre eux grillent avant d’avoir atteint l’obsolescence. Ces processeurs fonctionnent en permanence et sont soumis à de fortes températures, ce qui réduit la durabilité de leurs composants.

Microsoft affirme que la durée de vie des GPU se situe entre 2 et 6 ans. Le secteur utilise un cycle de 6 ans pour calculer l’amortissement de ces actifs, sans avoir le recul nécessaire pour valider cette hypothèse. On nage dans l’inconnu, comme l’expliquait récemment Bloomberg News. Le boom de l’IA repose ainsi sur un triple pari : cette technologie doit permettre des gains de productivité massifs à court terme, elle est censée déboucher sur une IA générale toute puissante à moyen terme et, plus concrètement, nécessite que les GPU au cœur de cette industrie affichent une durée de vie suffisante. La dépréciation trop rapide de ces actifs pourrait contraindre les entreprises qui les possèdent à enregistrer des pertes comptables significatives. Comme un grand nombre d’emprunts sont garantis par les stocks de GPU eux-mêmes, de multiples acteurs pourraient se retrouver avec des créances “pourries” sur les bras. Toute ressemblance avec la crise des subprimes de 2008 serait purement fortuite…

Les doutes sur la viabilité des investissements dans les data centers expliquent pourquoi l’entreprise CoreWeave, dont le modèle économique repose sur la location de temps de GPU à des clients comme OpenAI, a vu son action chuter de 22 % suite à l’annonce de ses résultats. Pour les mêmes raisons, le cours d’Oracle dévisse depuis des semaines et la note de sa dette a été abaissée par des institutions influentes.

Les craintes sont amplifiées par le manque de transparence du secteur. Outre les montages financiers complexes et les investissements circulaires, on peut noter que de nombreux acteurs ne sont pas cotés en bourse et ne publient pas leurs résultats. C’est le cas d’OpenAI, xAI, Anthropic, Perplexity, Mistral… Quant à Google, Microsoft, Amazon et Meta, leurs comptes de résultat ne distinguent pas nécessairement l’origine de leurs revenus ni les couts associés à l’IA. Microsoft rapporte sous la même ligne comptable les revenus tirés de ses data centers et de son assistant IA “Copilot”, par exemple. Autant d’incertitudes qui alimentent les craintes d’une crise imminente.

La limite ne sera pas nécessairement financière

Ces deux premiers risques (logiciels d’IA non rentables du fait de la guerre des prix et du manque de clients ; data centers non rentables du fait de la faible durée de vie des GPU et de la baisse des tarifs) restent essentiellement économiques et financiers. Le troisième risque majeur est de nature physique et politique.

Pour être opérationnels, les centres de données doivent être construits. Ce qui nécessite d’obtenir les permis, de franchir les différentes étapes juridiques et administratives pour autoriser leur construction, d’obtenir les terrains, d’ériger les bâtiments et de les alimenter en électricité. Tout cela prend du temps, malgré les simplifications mises en place par l’administration Trump ou le gouvernement Macron.

Comme le reconnaissait maladroitement Sam Altman (PDG d’OpenAI), le principal frein serait le manque d’électricité. Le Departement of Energy américain estime que les annonces actuelles nécessiteront le déploiement de 134 GW de puissance supplémentaire d’ici cinq ans. Soit plus d’un quart de la consommation électrique américaine de 2024 ou près de trois fois celle de la France. Actuellement, les États-Unis ajoutent 12 GW de puissance par an. On est loin du rythme nécessaire, sans parler des conséquences environnementales et sociétales d’une telle montée en puissance.

Aux USA, l’organisation du marché de l’électricité est tel que le raccordement d’un data center au réseau existant tend à faire bondir les factures électriques des riverains. Les entreprises qui construisent leurs propres centrales pour contourner ce problème en créent de nouveaux : la forte pollution induite localement provoque la colère des populations locales et expose ces firmes à divers risques juridiques. Et l’électricité n’est pas le seul enjeu. La forte consommation en eau potable des circuits de refroidissement des data centers augmente également les factures des riverains tout en occasionnant des impacts environnementaux parfois problématiques. Les questions d’accès à l’eau se mêlent à celles des factures plus salées.

Tout cela explique l’impopularité croissante des data centers aux USA. Ils sont en passe de devenir un enjeu politique incontournable (et transpartisan : n’importe quel élu local qui ne s’engagerait pas à s’y opposer risque une sanction électorale). Les data centers promis par OpenAI pourraient ne pas voir le jour où arriver plus tardivement, envoyant des signaux négatifs aux marchés. Dans l’Indiana, Google a renoncé à la construction d’un data center d’un milliard de dollars suite aux pressions des riverains. À travers le pays, le mouvement de résistance s’accélère. Entre avril et juillet 2025, 98 milliards de dollars de data centers ont été retardés ou annulés, selon le site Data Center Watch. Une hausse par rapport à la période précédemment étudiée (mai 2024 - mars 2025), où 64 milliards de dollars de projets auraient été impactés.

Passé l’euphorie initiale, l’annonce des résultats trimestriels de Nvidia a provoqué de nombreux doutes. Il semblerait que la firme ait inclus dans son chiffre d’affaires des ventes pas encore encaissées. Ce qui peut s’expliquer par les délais de paiement, bien que ces derniers semblent particulièrement longs comparés aux standards du secteur. L’autre explication serait que les clients de Nvidia n’ont pas encore été livrés, ou n’ont pas encore été en mesure de mettre en services les GPU livrés. Dans tous les cas, il semble y avoir un goulot d’étranglement quelque part.

Confronté aux doutes suscités par la publication de ses résultats, Nvidia a publié une note à l’intention des analystes financiers dans laquelle elle écrit “nous ne sommes pas Enron”. La comparaison n’est pas flatteuse : l’énergéticien représentait la 7e capitalisation boursière américaine avant de battre le record de la plus grosse faillite de l’histoire du pays. Une chute provoquée par la découverte de l’ampleur du maquillage des comptes financiers de l’entreprise, qui avait recours à des montages rappelant ceux qu’on observe dans le domaine de l’IA avec les SPV.

Après le “DeepSeek Impact”, l’OVNI Gemini ?

La dernière inconnue pouvant provoquer l’effondrement de l’édifice financier au cœur de la ruée vers l’IA tient dans la nature du secteur en question. Il est question de technologie et d’innovation, dans un domaine qui évolue très rapidement. Les chocs disruptifs font partie du paysage.

Au début de l’année, l’irruption de l’IA chinoise DeepSeek avait fait souffler un vent de panique sur la Silicon Valley. Wall Street avait subi une correction boursière impactant aussi bien Nvidia que diverses entreprises de semi-conducteurs, data centers et fournisseurs d’électricité. En cause, le fait que DeepSeek égalait les performances des meilleurs modèles américains du moment pour une fraction du cout et sans avoir eu accès aux meilleurs GPU de Nvidia pour concevoir le modèle. Les doutes sur la véracité de ces faits et le cantonnement de DeepSeek au marché chinois avaient rapidement gommé les craintes des investisseurs. Mais le risque d’autres évènements de ce genre persiste.

La semaine dernière, Google a publié la dernière version de Gemini, son propre LLM. Le modèle semble nettement supérieur à ChatGPT-5, du moins lorsqu’on le soumet aux critères d’évaluations utilisés par l’industrie. OpenAI a vu son avantage concurrentiel s’évaporer en quelques jours. Au point de provoquer une forme de panique au sein de l’entreprise, Sam Altman appelant ses employés à se mettre sur le pied de guerre.

Ce n’est pas tout. Gemini 3 n’a pas été entrainé à l’aide d’une armée de GPU Nvidia, mais sur les TPU de Google. Ce n’est pas une faute de frappe, j’ai bien écrit TPU, pour Tensor Processing Unit. Il s’agit d’un autre type de puces électroniques, conçues et produites par Google depuis 2016. Elles sont optimisées pour le calcul matriciel propre aux réseaux de neurones artificiels situés au cœur des IA génératives. Les TPU de Google ne sont pas nécessairement meilleurs que les GPU de Nvidia pour effectuer l’entrainement des modèles d’IA ou générer les inférences, mais ils sont suffisamment performants pour que Google se passe des GPU de Nvidia.

Non seulement Gemini 3 pourrait détruire l’avantage concurrentiel d’OpenAI, mais Google pourrait également s’attaquer au marché de Nvdia en commercialisant ses fameux TPU. Le risque est d’autant plus sérieux que Google dispose d’une puissance commerciale majeure et d’une capacité financière quasiment inégalée (100 milliards de dollars de réserve de liquidité, un taux d’endettement faible et des profits stables découlant de sa situation de monopole en matière de moteur de recherche). Meta serait déjà en discussion avec Google pour remplacer ses GPU par des TPU.

La sortie de Gemini 3 a provoqué une hausse de 8 % de l’action Google en une semaine, pendant que Nvidia et Oracle perdaient 8 et 13 % respectivement (et ce, après l’annonce des résultats meilleurs qu’escomptés de Nvidia). Sans tomber dans la pure spéculation, ce développement montre que les hypothèses sur lesquelles s’est construite la bulle IA peuvent être invalidées du jour au lendemain. ChatGPT pourrait rapidement devenir obsolète, les GPU de Nvidia pourraient ne plus valoir grand-chose, les créances ayant financés les data centers ne plus être remboursables, etc. Une simple baisse des profits de Nvidia pourrait allumer la mèche. Et gare à ceux qui se trouveront trop près des barils de poudre…